《论文阅读》SetGNER:General Named Entity Recognition as Entity Set Generation

0.总结

1. 动机

- 处理三种不同场景的NER

- 与 sequence-to-sequence NER 方法不同,本模型不需要强制实体按照顺序生成

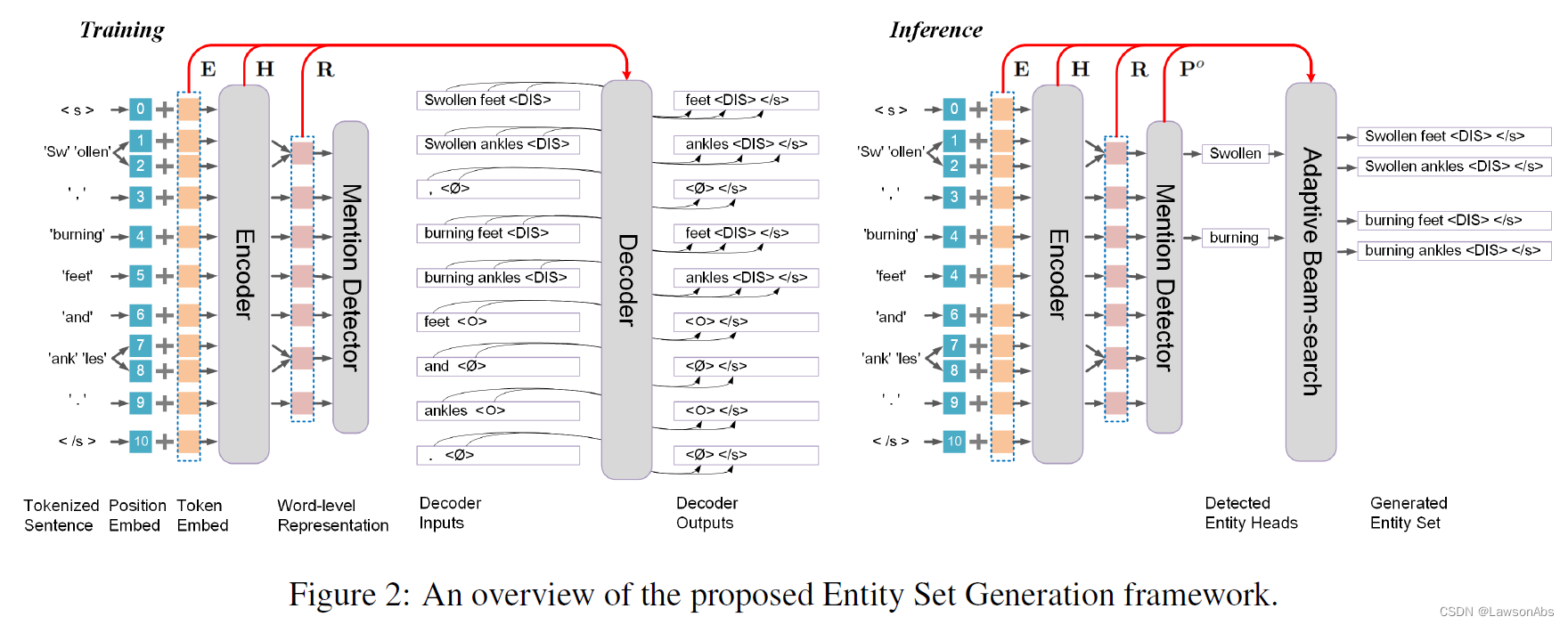

2. 方法

其实就是一个BART模型,然后里面套了几层简单的处理而已。

3. 训练细节

3.1 Inverse Generation Training

Since the forward generation task is biased towards the left-to-right semantic structure.

这话意思就是说:这种自回归的生成方法倾向于从左到右的语义结构。

于是提出使用一个 inverse generation training的方法让模型同时也掌握从右到左的语义结构。

做法:使用一个额外的解码器,同时训练生成实体尾 到实体头。举例如下:Swollen, burning feet and ankles. 对于这条句子,得到的翻转目标序列则是:

3.2 联合学习

将上述得到的各个损失进行联合优化。

4. 疑惑

主要的疑惑点有:

- Problem Formulation 中的对Ptr的定义。