ICLR2021清华团队做的知识蒸馏提升detector的点的工作paper 小陈读论文系列

这个作者栏目就是一个词 清爽 牛逼不需要花里胡哨哈哈 无疑是有点tian了哈哈 不重要

毕竟有机会研读 梦中情笑的paper 还是很感激的

真的 很清爽啊

很多KD的工作确实 在下游任务呢效果不是很好

然后就引出了自己的关于提升知识蒸馏在OD方面的工作

OD 首先就有两个问题 1.前景和背景的失衡

2. 缺少对不同像素点的蒸馏 啊这 确实有一说一 很细

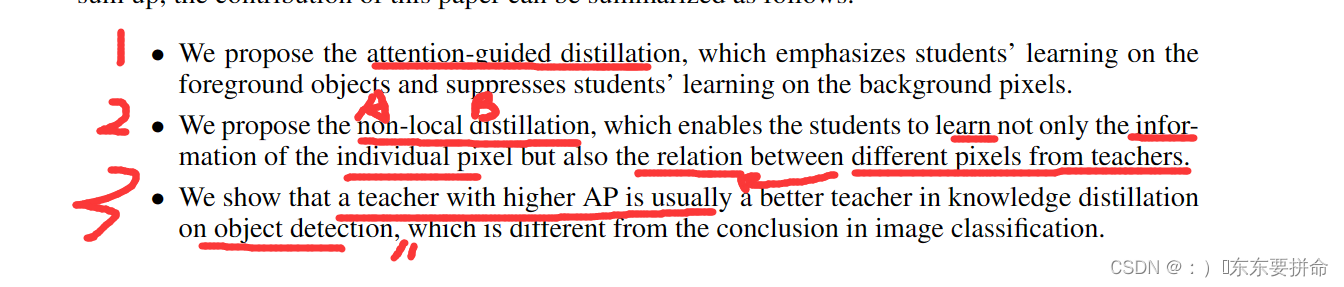

然后propose attention-guided distillation and non-local distillation

to address the two problems

这个 abstract 太清晰了

还是 好清爽啊啊啊啊啊 我好喜欢这个风格啊

1.通过这个attention的idea去找到关键像素(需要学习的)

2.Non-local distillation 的新方式

让学生可以学习到个别像素的feature

还可以学习不同像素之间的关系知识

两个点 清清爽爽 只能说很优雅

唯一美中不足的是没看到sota 是谦虚 还是效果确实没有sota 我现在也不知道啊

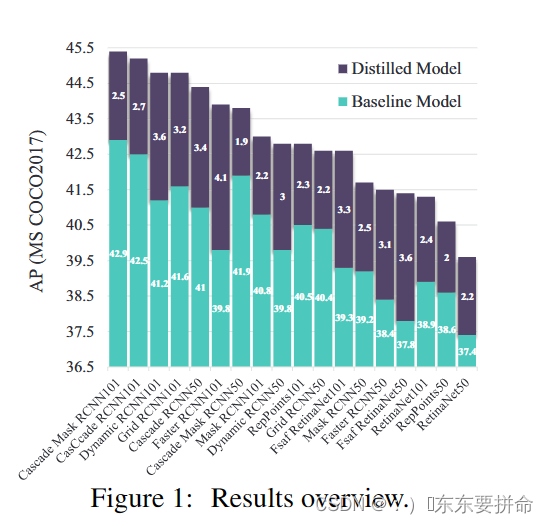

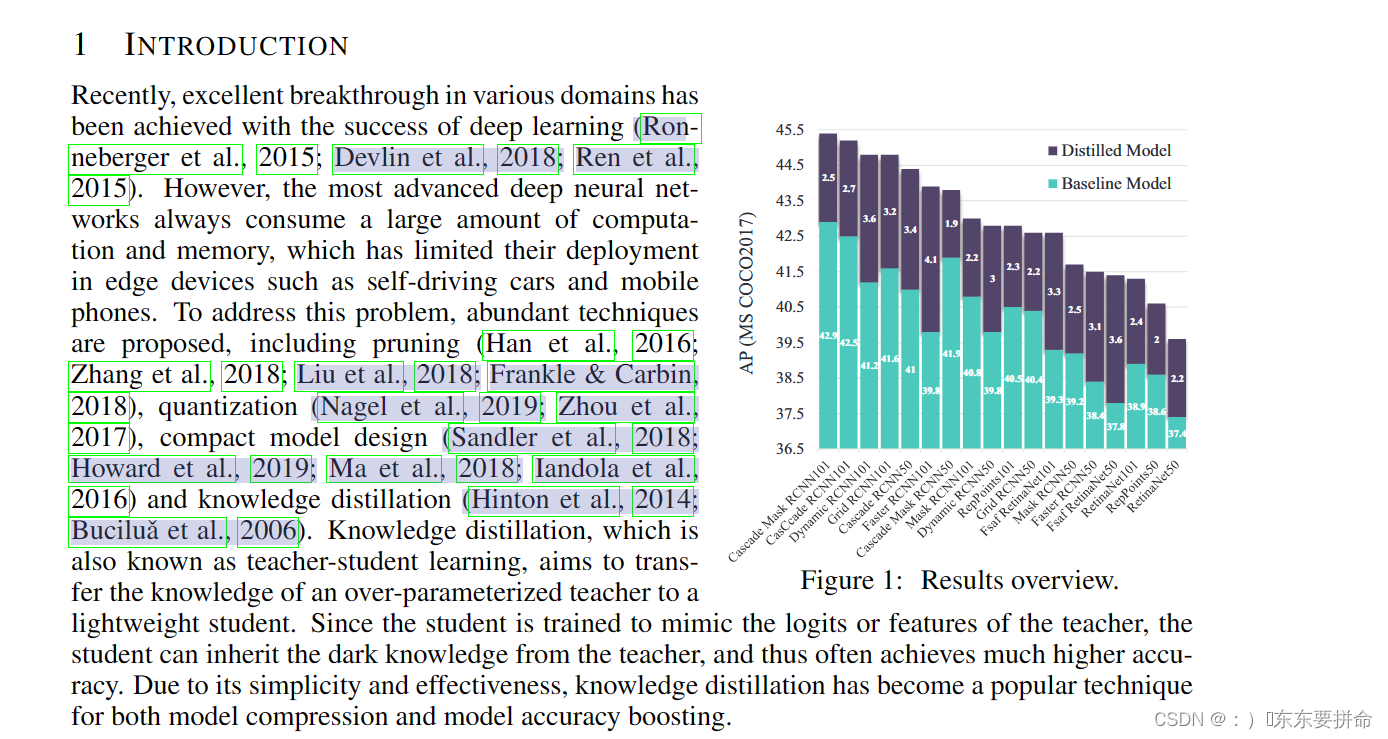

我之前先看的文章再看的图 我发现这样的思维很不好

大家不要学习 反面教材啊 先看图

这个标题 大概是摘要的补充 丰富而有明显

值得学习的是 颜色的搭配 和 数值的分布

很细 值得学习

我们也看到了这个工作 确实 很work

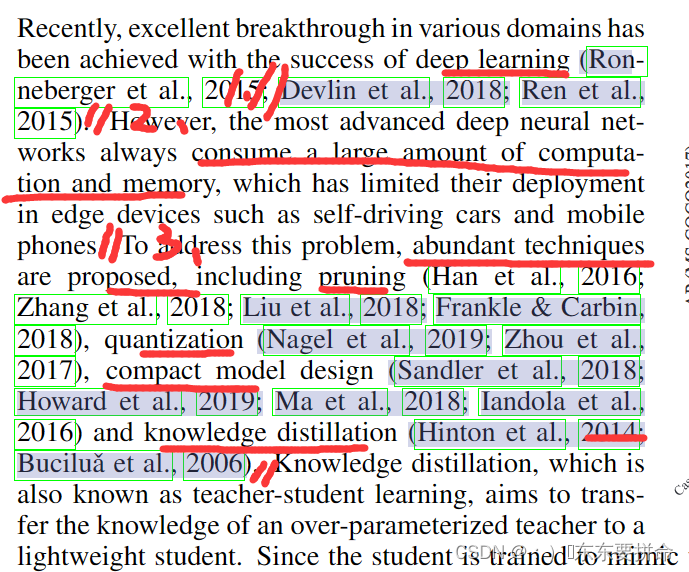

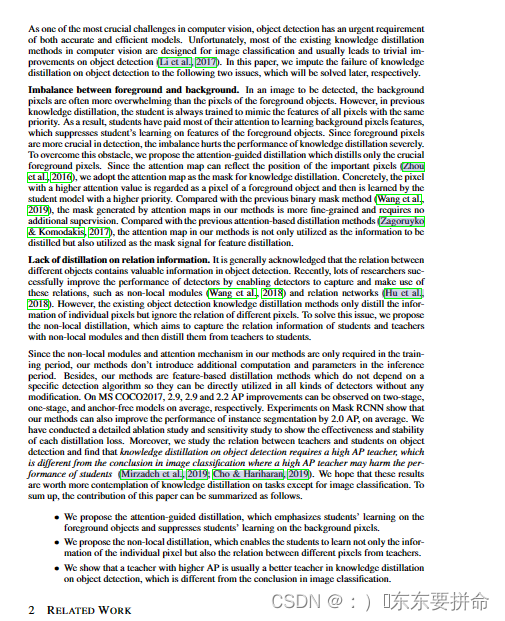

回到introduction部分

读的非常快 写法也很值得学习

1.说了深度学习很火交代了背景

2.交代问题

deep learning啊 就是耗费太多资源了 计算开销 内存损耗很离谱啊

动不动上百亿的参数(我说多了哈哈)

3.解决这个 burdensome的问题呢 大家是怎么做的

剪枝量化 模型压缩 知识蒸馏 我都看烂了 大概这就是为什么后来大家看自己领域的paper 越来越快了吧

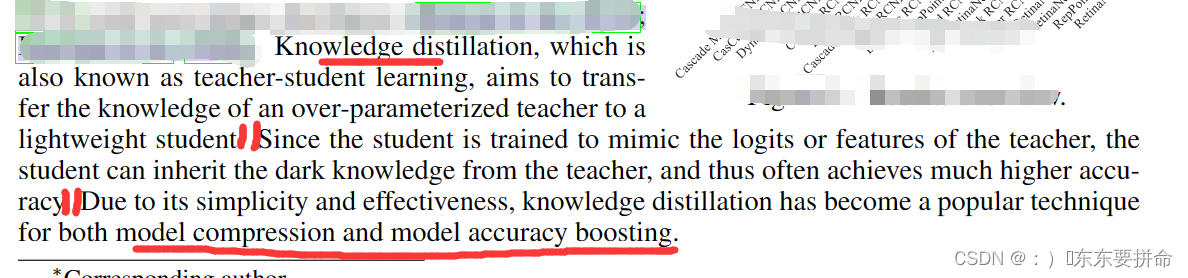

这结构就是漂亮 最后介绍一下 知识蒸馏是一个很nice 的技术 大致怎么做的

最后这个 排版也是 很不错的

都不用翻页

假的吧 这个introduction就一页多一点

爱了爱了

先抑后扬啊 不幸的是大多都是为图像分类设计 对检测的提升不多 学习一下这个单词

trivial improvements

微不足道的改进

说的就是委婉哈哈

然后就是他们的工作呢 解决两个痛点

前景和背景的不平衡到底多影响嘞

因为我们发现大多数的自然图像图片中,背景所占整张图的比重太大了

而要检测的物体所占的前景部分相比就要小很多,然后之前的知识蒸馏都是让学生去学习整张图的attention 就会抑制真正的关键的前景信息

而过多的不重要的信息就会影响知识蒸馏的效果

原来这个 才是goodideal啊 直接上升维度做 深入到里面去做研究

这个研究是有深度的

不过这里就要有点排斥了。。。批判的思维看问题吧确实有点想法的

不过回到文章中

重要的手段是

只想蒸馏出关键的前景知识 加上权重 赋予优先级 具体的得看代码实现

这里的知识形式 attention map

这是第二个创新 我不是很懂 改天真的需要好好学习 基于关系知识的知识蒸馏形式

但是这里表达很清楚

之前的方法的缺陷:只关注个别像素的 关系知识,而忽视了不同像素之间的关系

然后提出了可以捕捉 不同像素之间关系知识的

箭头到后面一个地方说的 最好的老师可能教不出来的最好的学生在目标检测这篇工作下好像矛盾

这篇paper发现需要高AP才能教好学生 (这个点可以写)

箭头前面总结了一下自己的工作

箭头中展示一下结果

最后 叙述contribution

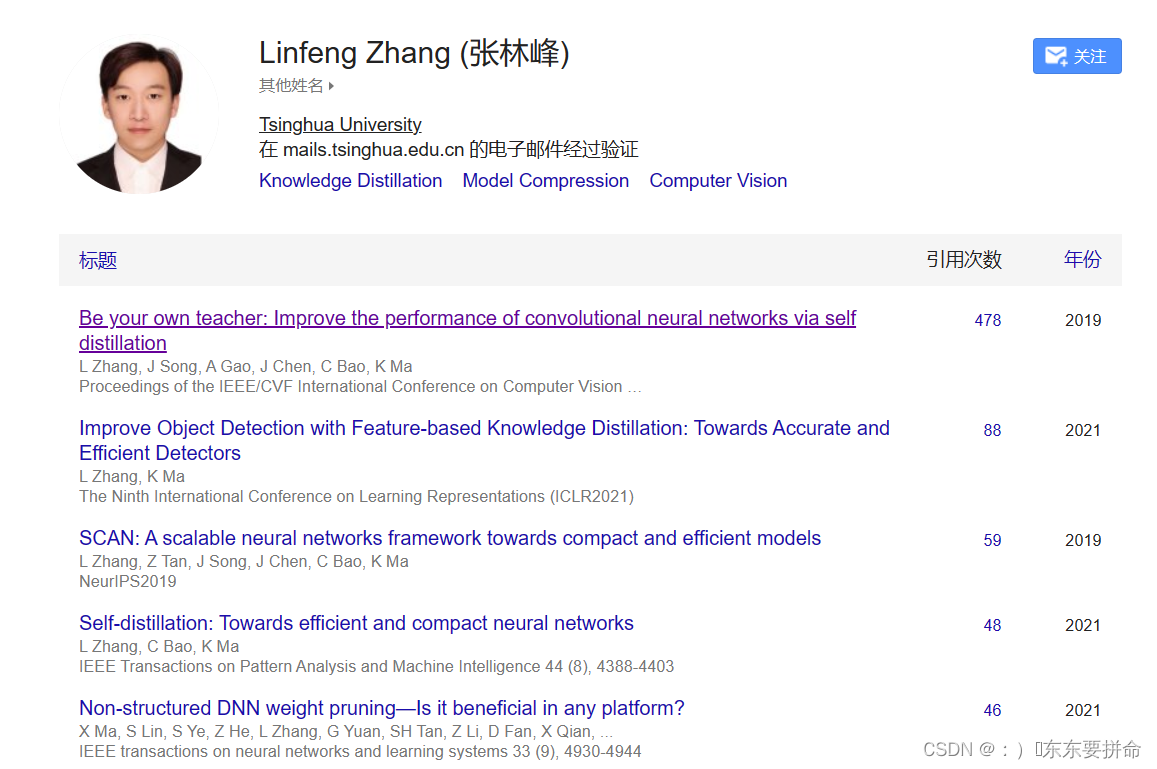

写作风格 我好喜欢 我感觉就是理想中paper的样子 我去搜一下谁写的

写作风格 我好喜欢 我感觉就是理想中paper的样子 我去搜一下谁写的

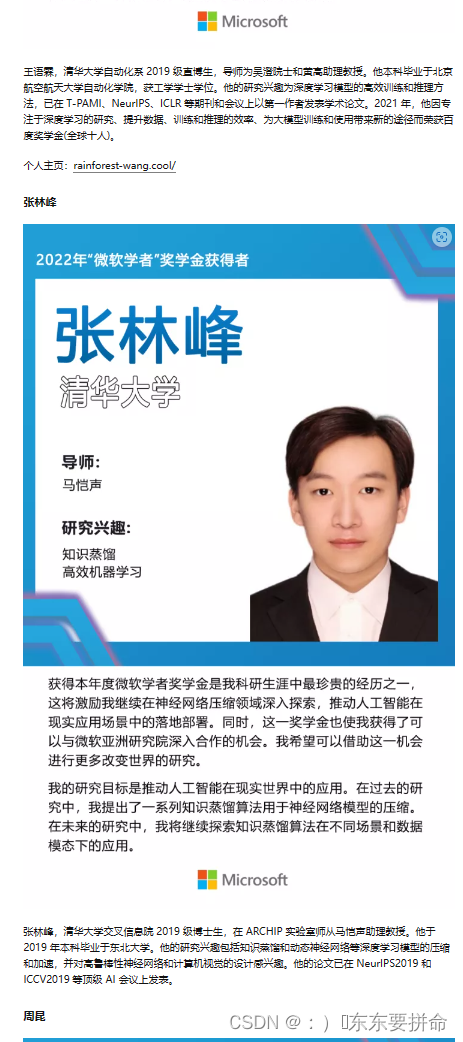

做知识蒸馏的大牛呢 怪不得

直博的嘛 啊 这么牛 是个清华博士