概率机器学习笔记

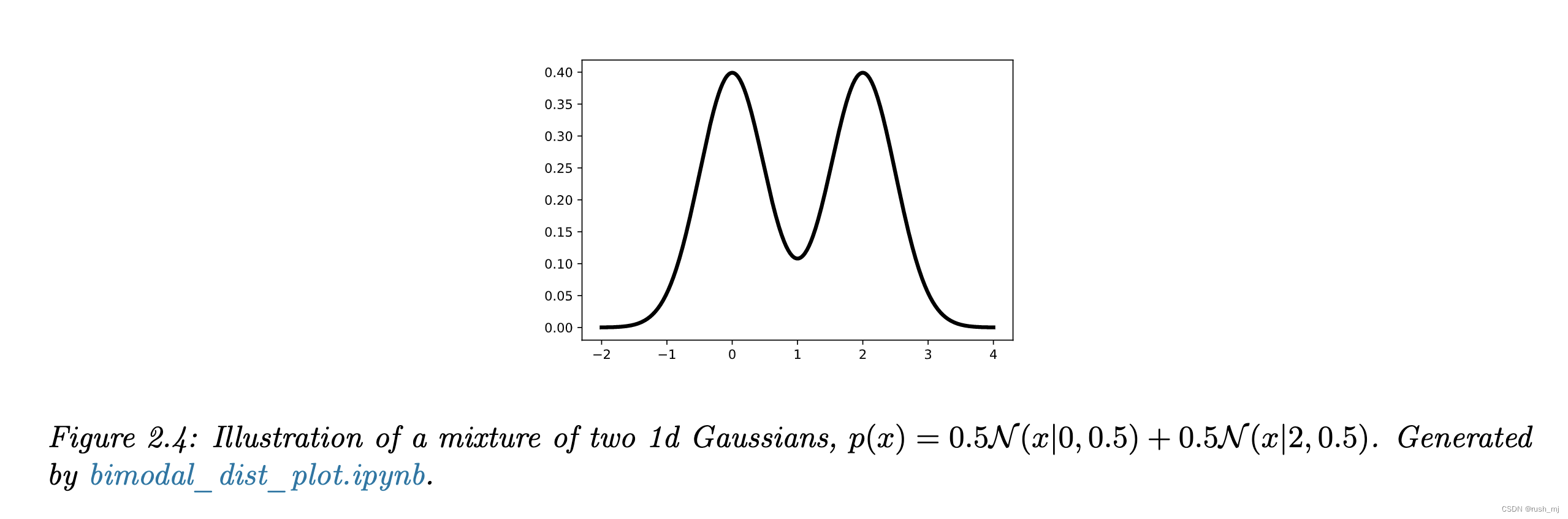

1.单变量高斯混合分布

原书对结果的得出没有给出解释,我比较困惑,网上找到了一篇推导的帖子,看完就明白了。

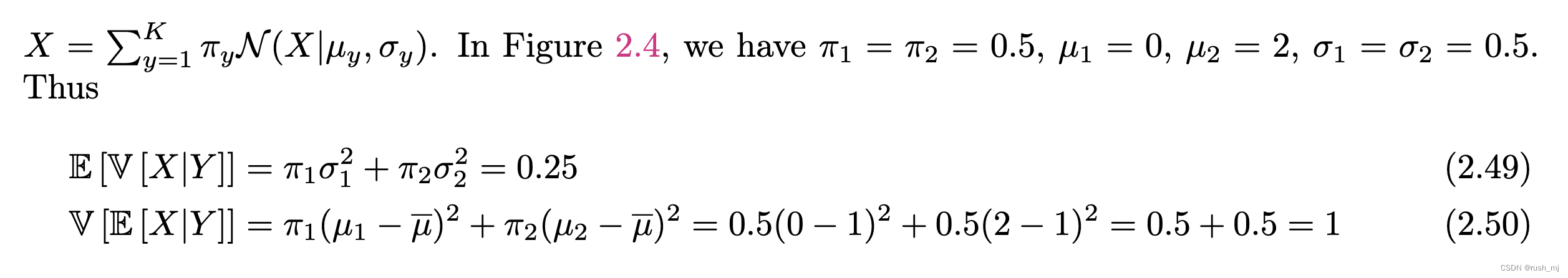

式2.49的解释:

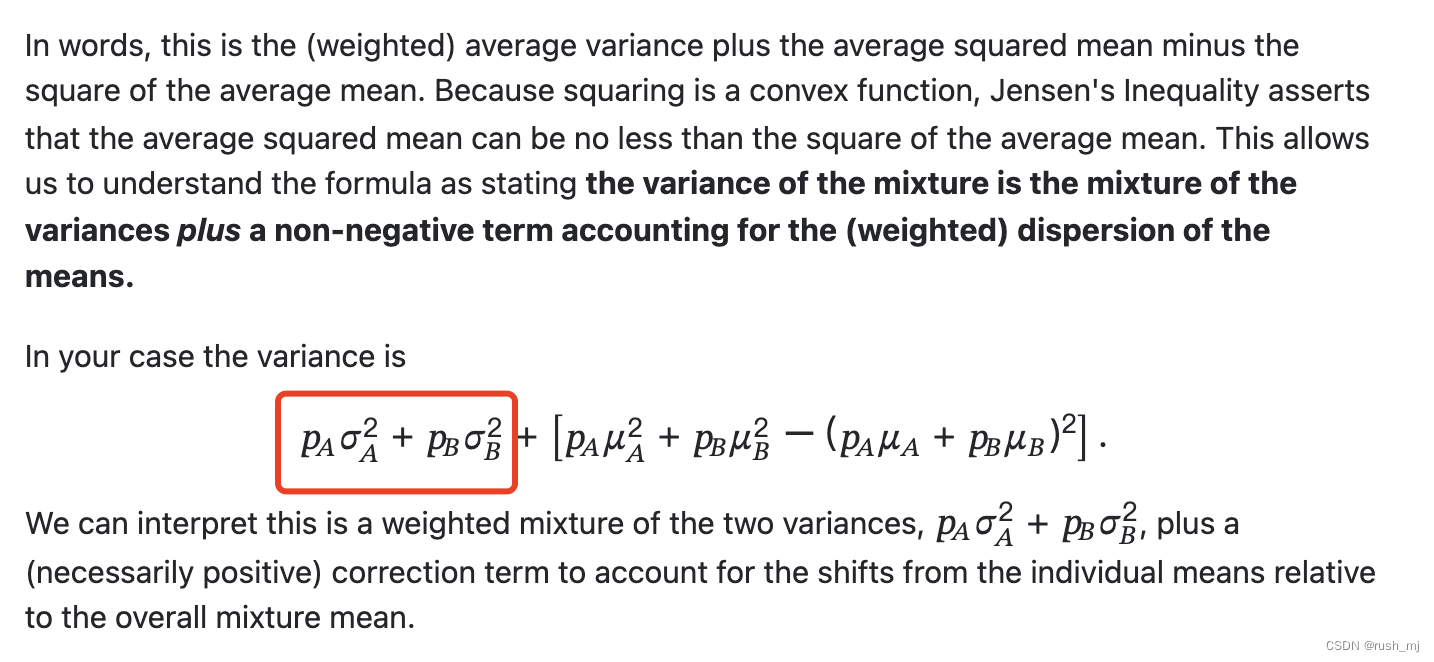

红框即为关键处,这是显而易见的期望,不过是条件方差的期望:

该证明的作者:@MISC {16609,

TITLE = {What is the variance of the weighted mixture of two gaussians?},

AUTHOR = {whuber (https://stats.stackexchange.com/users/919/whuber)},

HOWPUBLISHED = {Cross Validated},

NOTE = {URL:https://stats.stackexchange.com/q/16609 (version: 2015-05-20)},

EPRINT = {https://stats.stackexchange.com/q/16609},

URL = {https://stats.stackexchange.com/q/16609}

}

这是一个完美的 的推导。

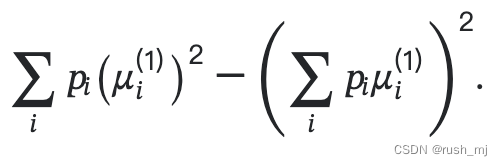

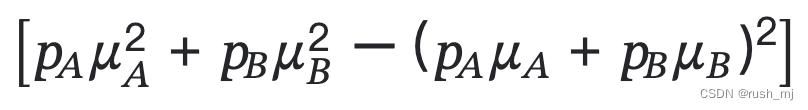

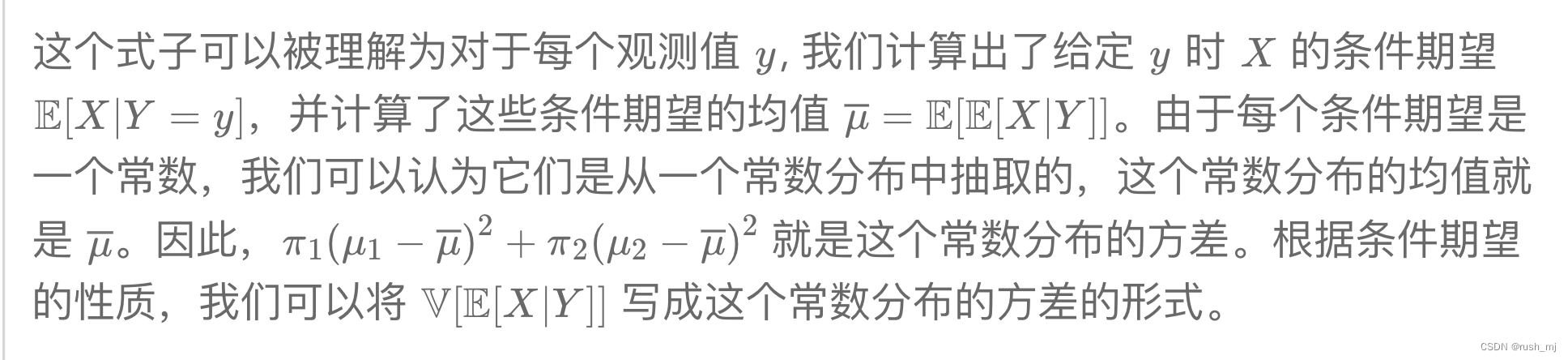

式2.50的解释:

在刚刚的推导里如下公式,按这个也可以解

但是作者的思路用了,这就让人看不懂,所以询问了GPT,GPT给出了解答:

这两个证明都是基于直觉的,所以容易理解。