机器学习——线性模型之Softmax回归

问:Softmax回归模型是一种典型处理多分类任务的非线性分类模型

答:错误。Softmax回归是线性分类模型。实际上是逻辑回归的拓展,它将逻辑回归的二分类推广到了多分类,用逻辑回归的方法解决多分类问题。

线性模型——Softmax回归

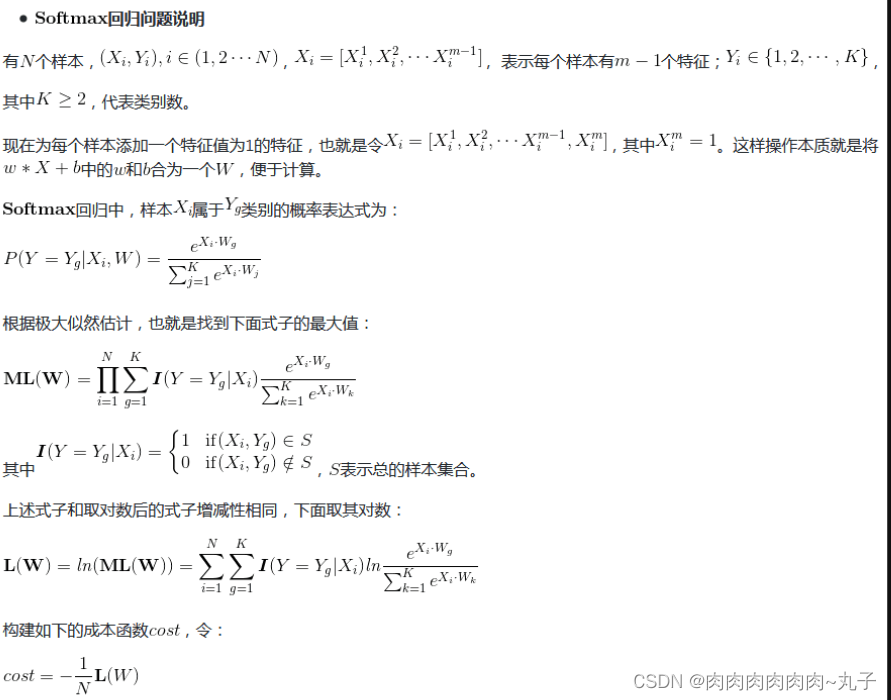

Softmax回归模型是一种用于分类问题的模型。它的主要思想是将每个类别的得分(或者说是概率)通过一个函数进行归一化,使得所有类别的概率之和等于1。这个函数就是Softmax函数,从而进行分类决策。在训练模型时,我们会通过最小化损失函数来调整模型参数,使得模型的预测结果与真实结果尽可能地接近。在实际应用中,Softmax回归模型经常被用来处理多分类问题,比如图像分类、自然语言处理等。

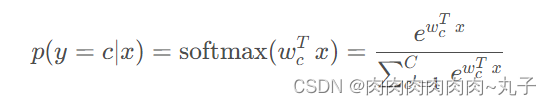

在学习softmax回归之前,需要先了解两个知识点,一个是softmax函数,另一个是One-Hat编码。softmax函数和逻辑回归中的sigmoid函数的作用一样,都是为了将线性回归的连续值转换为离散值,从而完成分类任务,不同之处在于,sigmoid将连续值转换为0和1,而对于一个C CC分类问题来说,softmax函数则是转换为{ 1 , 2 , 3... , C } \\{1,2,3...,C\\}{1,2,3...,C}。softmax函数表达式为:

Softmax 回归模型有以下几个特点:

- 对于每个类别,都存在一个独立的、实值加权向量

- 这个权重向量通常作为权重矩阵中的行。

- 对于每个类别,都存在一个独立的、实值偏置量b

- 它使用 softmax 函数作为其激活函数

- 它使用交叉熵( cross-entropy )作为损失函数