【大数据之Hadoop】十三、MapReduce之WritableComparable排序

MapReduce框架必须进行排序,MapTask和ReduceTask都会对key按字典顺序排序,是默认的行为(默认使用快速排序),有利于提高效率。任何程序数据都会进行排序,不管逻辑是否需要。

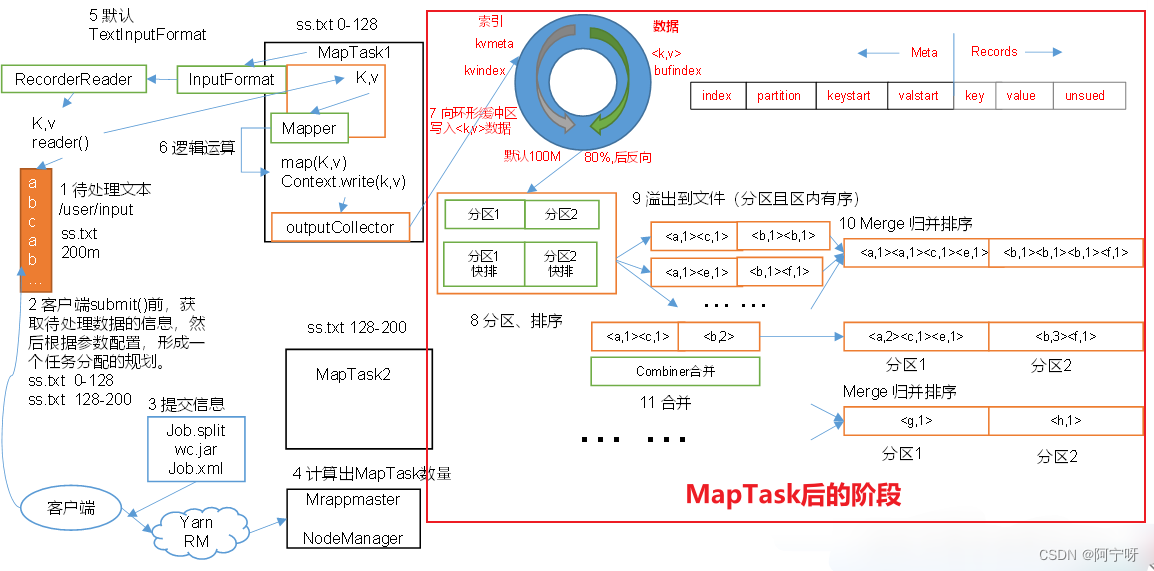

对于排序而言分为两个阶段,MapTask后和ReduceTask前。

MapTask后的阶段:

MapTask把处理结果暂时放到环形缓冲区,当环形缓冲区的使用率达到一定阈值(80%)时,对其进行一次快速排序,然后将有序数据写到磁盘上。

当数据处理完后,磁盘上的所有文件再进行一次快速排序。

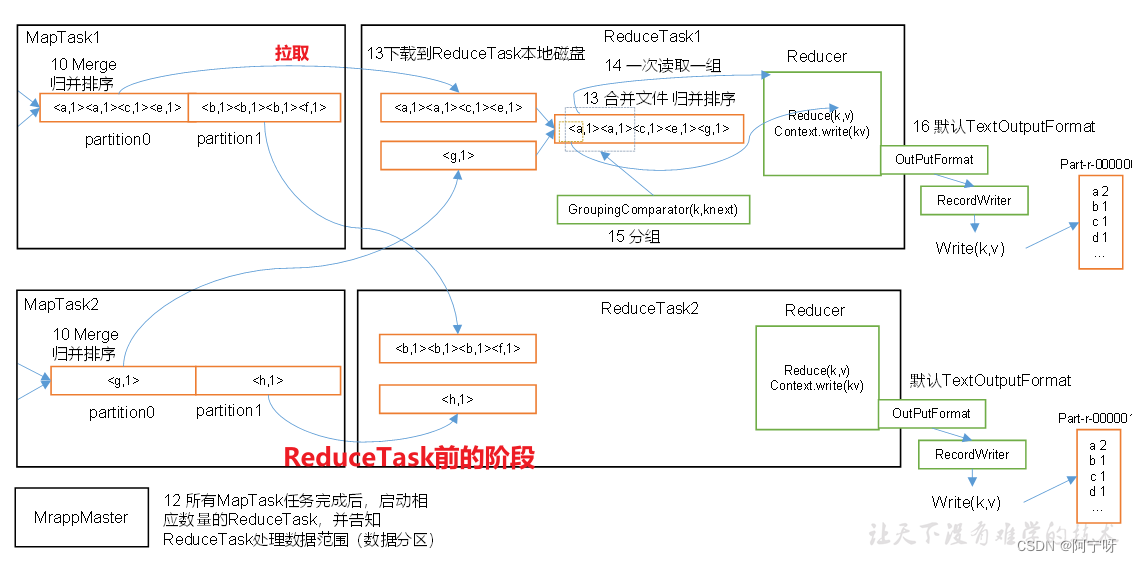

ReduceTask前的阶段:

ReduceTask从每个MapTask上拉取数据存储在内存上,如果文件太大则溢出写道磁盘。

如果磁盘上的文件数目达到一定阈值时,则进行一次归并排序,生成更大的文件。

如果内存中文件大小或者数目达到一定阈值时,也进行一次合并排序后写到磁盘上。

当所有数据拉取完毕后,ReduceTask统一对内存和磁盘上的所有数据进行一次归并排序。

(1)部分排序:MapReduce根据输入的键进行排序,保证输出的每个文件内部的有序。

(2)全排序:最终输出结果只有一个文件,且文件内部有序。(实现:只设置一个ReduceTask,处理大型文件效率很低,相当于只有一台机器处理文件)

(3)辅助排序(GroupingComparator分组):在reduce端对key进行分组。(用于在接受key为bean对象时让一个或多个字段相同的key进入到同一个reduce方法)

(4)二次排序:自定义排序中,compareTo的判断条件为2个时。

原理:

bean对象做为key传输,需要实现WritableComparable接口重写compareTo方法进行排序。

@Override

public int compareTo(FlowBean bean) {int result;//按照总流量大小,倒序排列if(this.sumFlow > bean.getSumFlow()) {result= -1;}elseif (this.sumFlow < bean.getSumFlow()) {result= 1;}else{result= 0;}return result;

}