各种深度学习机器学习数据集(大多数内附读取脚本!)(建议按ctrl+F查询是否有需要的,持续更新中。。)

欢迎关注,高强度更新和MATLAB,PYTHON编程,C++编程,算法编程,深度学习,自然语言处理,图像处理,OPENCV等相关知识:)

摘要

MNIST数据集、行人车辆检测数据集、安全头盔数据集、白酒数据集、成人数据集、口罩检测数据集、车牌数据集及完整项目、行李箱数据集、神经网络等

各种数据集(建议按ctrl+F查询是否有需要的,持续更新中。。

- 摘要

- 各种深度学习机器学习数据集(大多数内附读取脚本!)(建议按ctrl+F查询是否有需要的,持续更新中。。)

- 行人检测数据集

- ChineseMNIST数据集

- MNIST数据集(解压包中有加载的代码及数据集!)

- Adult数据集

- 白酒质量数据集

- garbage_classify_et.zip(垃圾分类数据集在zip文件中包含一个训练的脚本,可直接使用!)

- 安全盔安全衣数据集(一步到位,适合小白!)

- 人工标注的人脸与戴口罩人脸数据集(VOC)格式

- 行李箱内物品检测数据集VOC格式

- 车牌识别数据集1(主要是opencv来识别)

-

- 完整项目代码下载链接

- 车牌识别数据集2(目标检测算法,标准的标签格式)

-

- 完整项目代码下载链接

各种深度学习机器学习数据集(大多数内附读取脚本!)(建议按ctrl+F查询是否有需要的,持续更新中。。)

行人检测数据集

下载链接

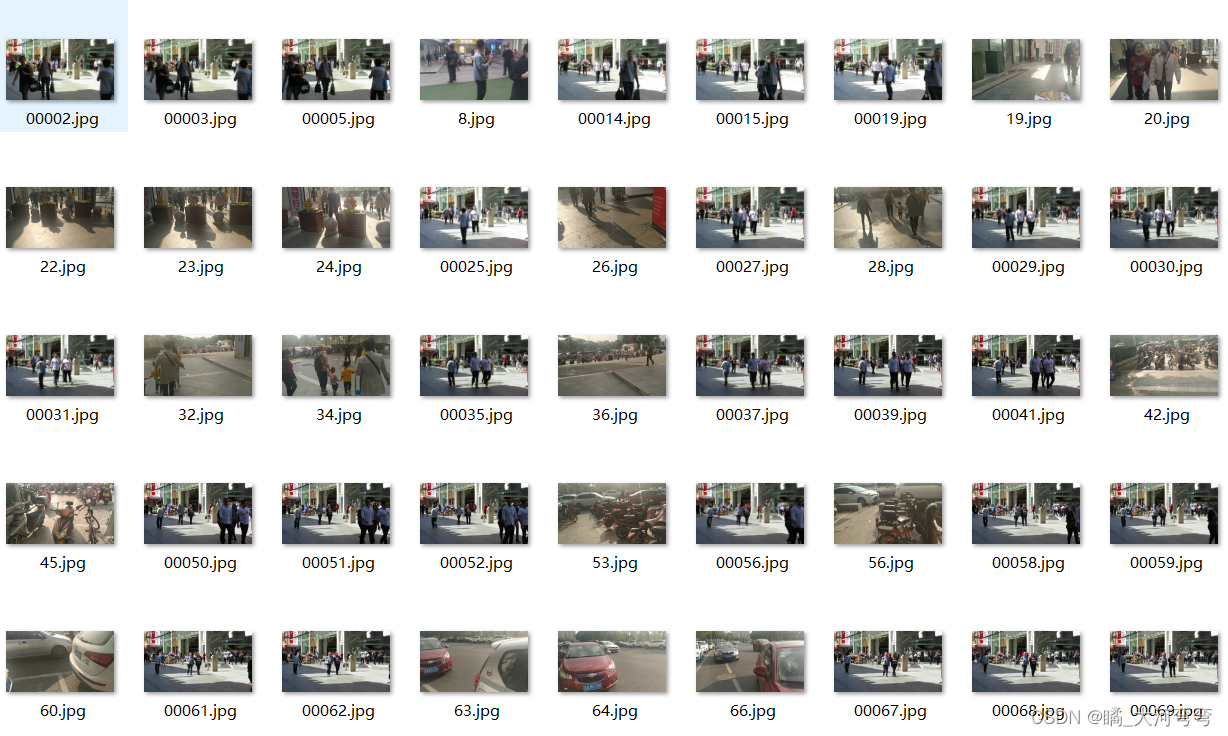

行人车辆检测数据集一共4500张验证集500张,我使用yolov5检测,map能高达98%!效果显著。

部分图片展示:

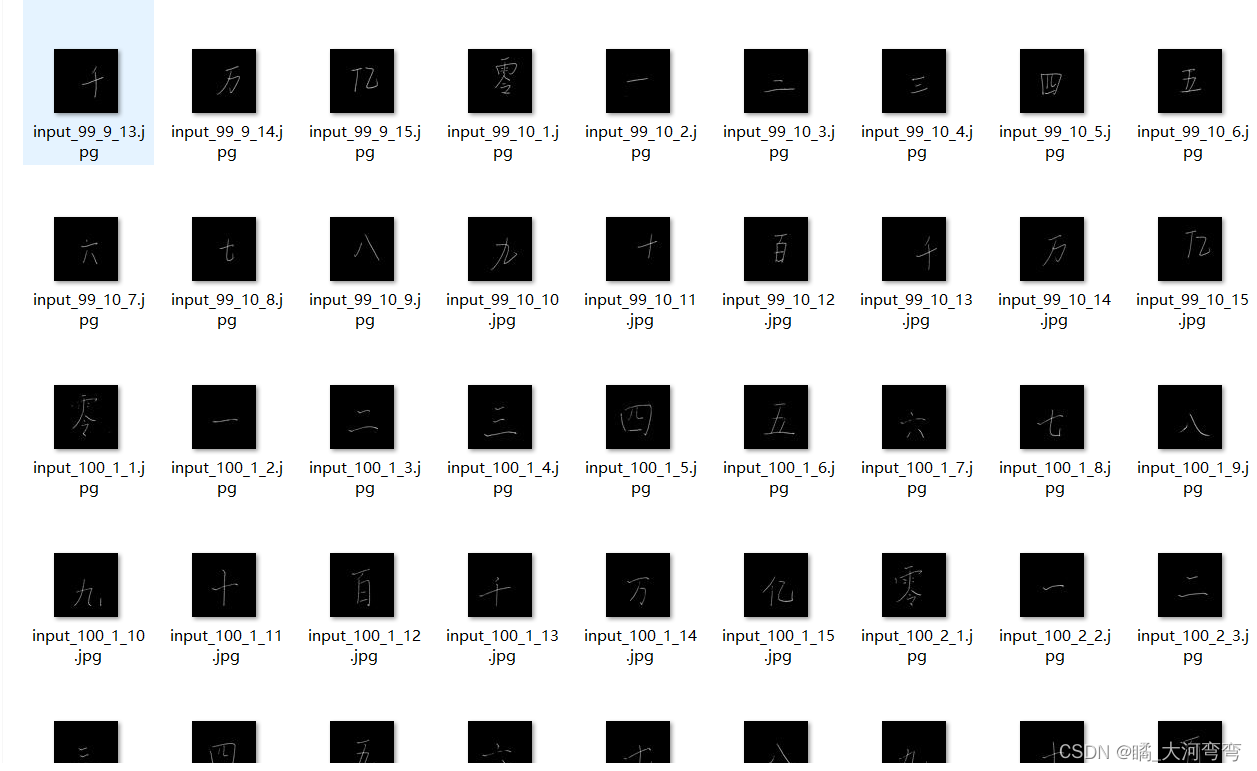

ChineseMNIST数据集

下载链接

部分图片展示:图片大小为64*64,一共15W张。

MNIST数据集(解压包中有加载的代码及数据集!)

下载链接

原始的MNIST数据集,如果是matlab读取的话,可以使用一下代码:

建立一个loadMNISTLabels.m脚本读取标签:

function labels = loadMNISTLabels(filename)

%loadMNISTLabels returns a [number of MNIST images]x1 matrix containing

%the labels for the MNIST imagesfp = fopen(filename, 'rb');

assert(fp ~= -1, ['Could not open ', filename, '']);magic = fread(fp, 1, 'int32', 0, 'ieee-be');

assert(magic == 2049, ['Bad magic number in ', filename, '']);numLabels = fread(fp, 1, 'int32', 0, 'ieee-be');labels = fread(fp, inf, 'unsigned char');assert(size(labels,1) == numLabels, 'Mismatch in label count');fclose(fp);end建立一个loadMNISTImages.m脚本读取图片:

function images = loadMNISTImages(filename)

%loadMNISTImages returns a 28x28x[number of MNIST images] matrix containing

%the raw MNIST imagesfp = fopen(filename, 'rb');

assert(fp ~= -1, ['Could not open ', filename, '']);magic = fread(fp, 1, 'int32', 0, 'ieee-be');

assert(magic == 2051, ['Bad magic number in ', filename, '']);numImages = fread(fp, 1, 'int32', 0, 'ieee-be');

numRows = fread(fp, 1, 'int32', 0, 'ieee-be');

numCols = fread(fp, 1, 'int32', 0, 'ieee-be');images = fread(fp, inf, 'unsigned char');

images = reshape(images, numCols, numRows, numImages);

images = permute(images,[2 1 3]);fclose(fp);% Reshape to #pixels x #examples

images = reshape(images, size(images, 1) * size(images, 2), size(images, 3));

% Convert to double and rescale to [0,1]

images = double(images) / 255;endAdult数据集

下载链接

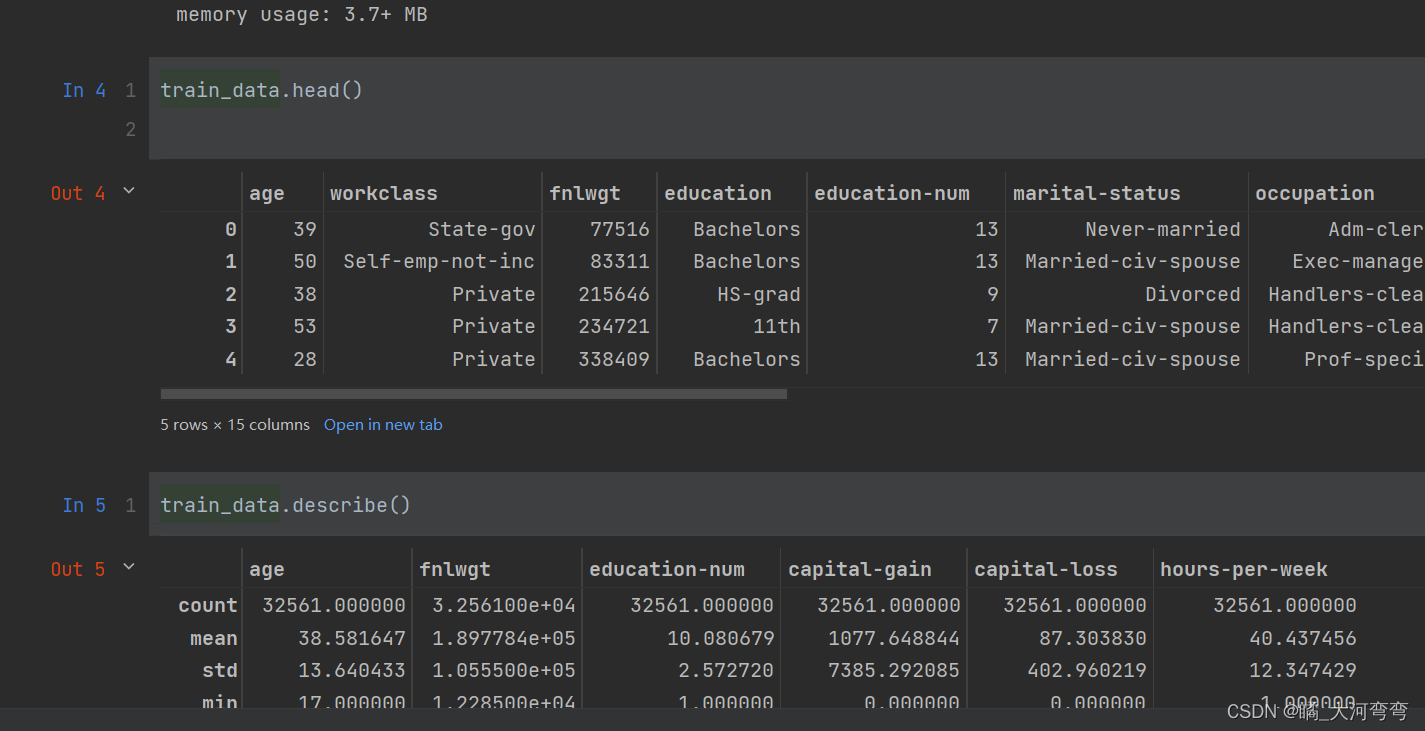

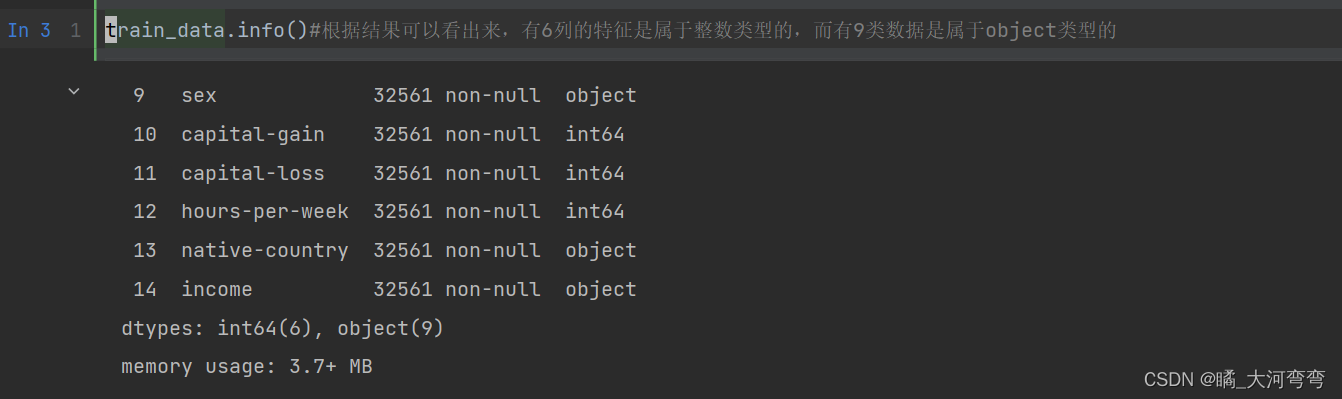

该数据从美国1994年人口普查数据库中抽取而来,因此也称作“人口普查收入”数据集,共包含48842条记录,年收入大于50k的占比76.07%,数据集已经划分为训练数据32561条和测试数据16281条。该数据集类变量为年收入是否超过50k

解压文件夹内包含一个读取数据集的py脚本文件,0基础小白轻松上手使用!

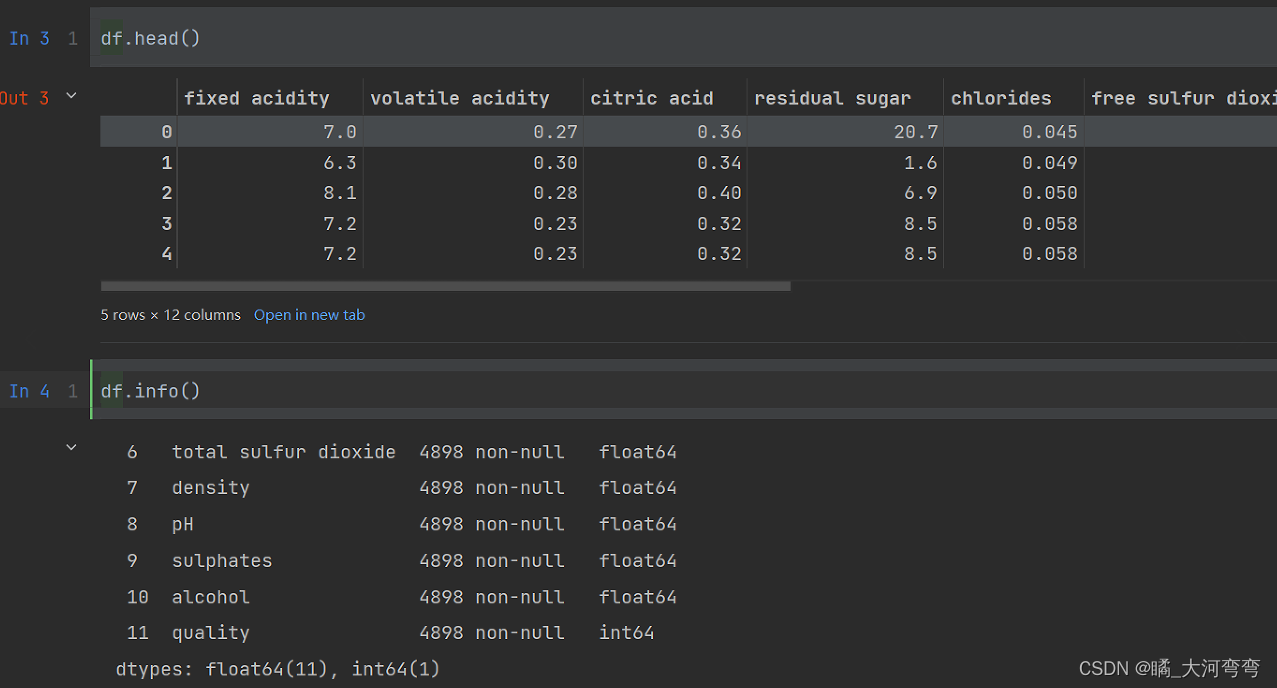

白酒质量数据集

下载链接

著名的机器学习数据集,解压包中含有该数据集以及一个.py脚本,运行该脚本可以直接把数据集加载到python中去0基础小白轻松上手使用!

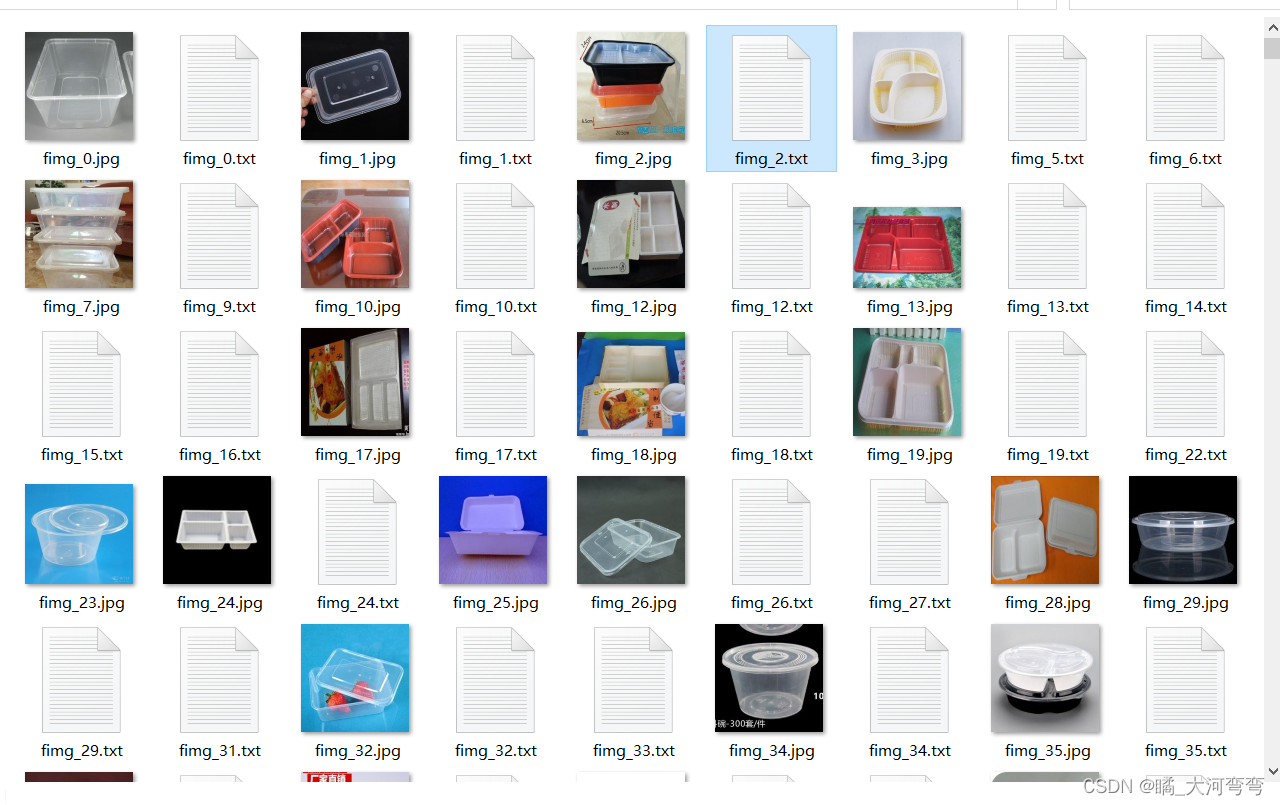

garbage_classify_et.zip(垃圾分类数据集在zip文件中包含一个训练的脚本,可直接使用!)

下载链接

数据集说明一共4大类,40小类,在zip文件中包含一个训练的脚本,可直接使用!一共4000多个数据:

部分图片:

{

"0": "其他垃圾/一次性快餐盒",

"1": "其他垃圾/污损塑料",

"2": "其他垃圾/烟蒂",

"3": "其他垃圾/牙签",

"4": "其他垃圾/破碎花盆及碟碗",

"5": "其他垃圾/竹筷",

"6": "厨余垃圾/剩饭剩菜",

"7": "厨余垃圾/大骨头",

"8": "厨余垃圾/水果果皮",

"9": "厨余垃圾/水果果肉",

"10": "厨余垃圾/茶叶渣",

"11": "厨余垃圾/菜叶菜根",

"12": "厨余垃圾/蛋壳",

"13": "厨余垃圾/鱼骨",

"14": "可回收物/充电宝",

"15": "可回收物/包",

"16": "可回收物/化妆品瓶",

"17": "可回收物/塑料玩具",

"18": "可回收物/塑料碗盆",

"19": "可回收物/塑料衣架",

"20": "可回收物/快递纸袋",

"21": "可回收物/插头电线",

"22": "可回收物/旧衣服",

"23": "可回收物/易拉罐",

"24": "可回收物/枕头",

"25": "可回收物/毛绒玩具",

"26": "可回收物/洗发水瓶",

"27": "可回收物/玻璃杯",

"28": "可回收物/皮鞋",

"29": "可回收物/砧板",

"30": "可回收物/纸板箱",

"31": "可回收物/调料瓶",

"32": "可回收物/酒瓶",

"33": "可回收物/金属食品罐",

"34": "可回收物/锅",

"35": "可回收物/食用油桶",

"36": "可回收物/饮料瓶",

"37": "有害垃圾/干电池",

"38": "有害垃圾/软膏",

"39": "有害垃圾/过期药物"

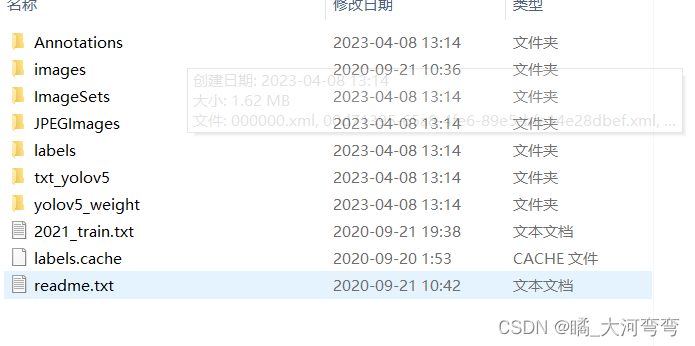

} 安全盔安全衣数据集(一步到位,适合小白!)

下载链接

1083张反光衣的数据集,数据集文件包含jpg图片和xml文件,数据集主要四类标注:带头盔的人、没带头盔的人、穿反光衣的人、未穿反光衣的人,主要标注反光衣,识别效果能达到百分之98以上,同时里面还有训练好的yolov5的权重数据,达98%!直接使用load命令即可,一步到位

解压包内容如下:

人工标注的人脸与戴口罩人脸数据集(VOC)格式

下载链接

- 数据来源:Google、Baidu

- 数据质量:最小图像为10.8K,全部为jpg格式

- 数据集大小:全部使用lableImg工具手工标注,数据格式为VOC格式

| 图像总数 | 人脸总数 | 未佩戴口罩人脸数 | 佩戴口罩人脸数 |

|---|---|---|---|

| 498 | 1245 | 619 | 626 |

数据集组织形式:

训练图片示例:

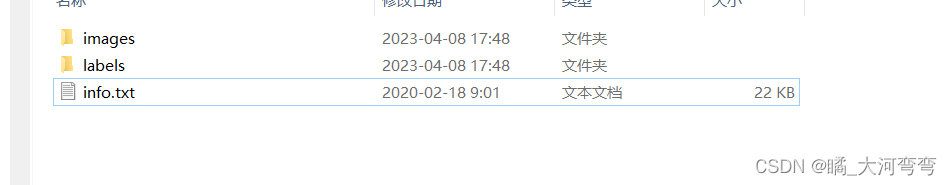

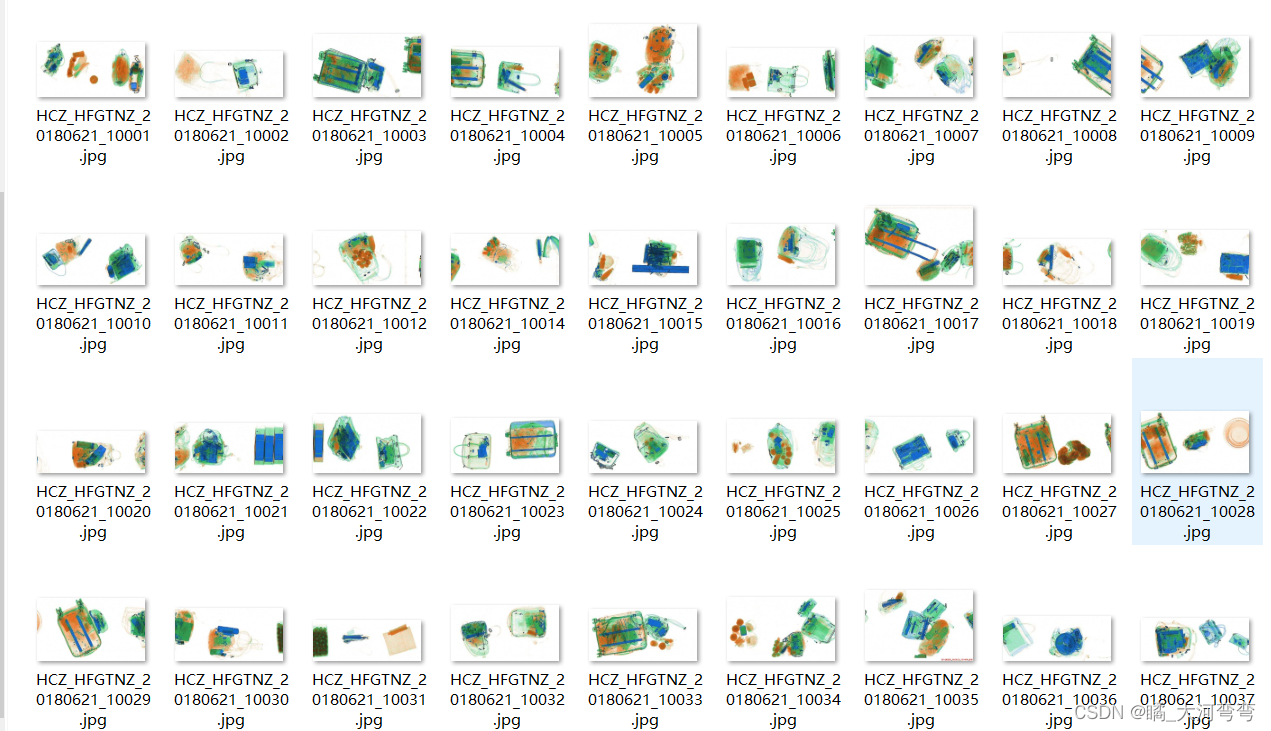

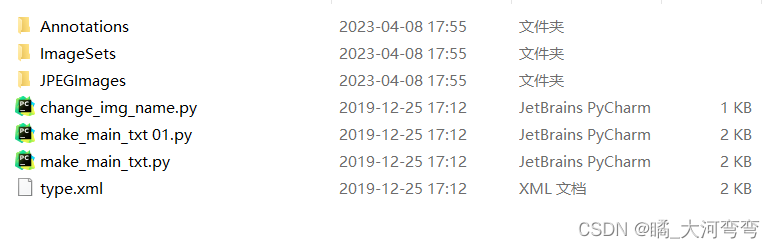

行李箱内物品检测数据集VOC格式

下载链接

该数据集为行李箱物品检测数据集,是多目标检测任务,一共含有521个数据,图片如图所示:

文件包含内容:

可无缝与YOLO等目标检测算法应用。

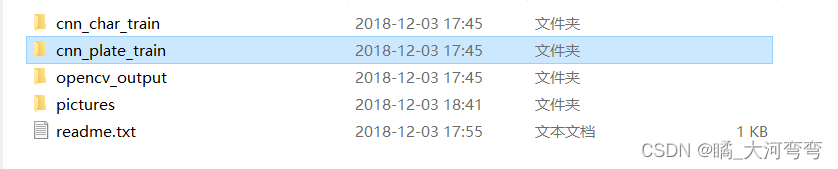

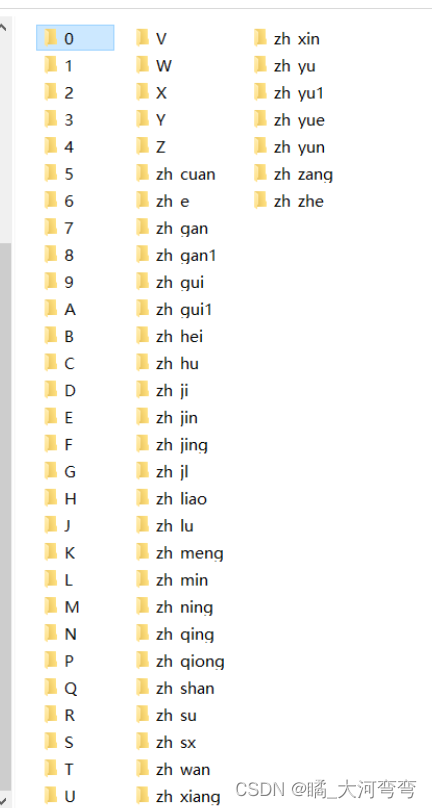

车牌识别数据集1(主要是opencv来识别)

数据集下载链接

数据集供分为三部分:

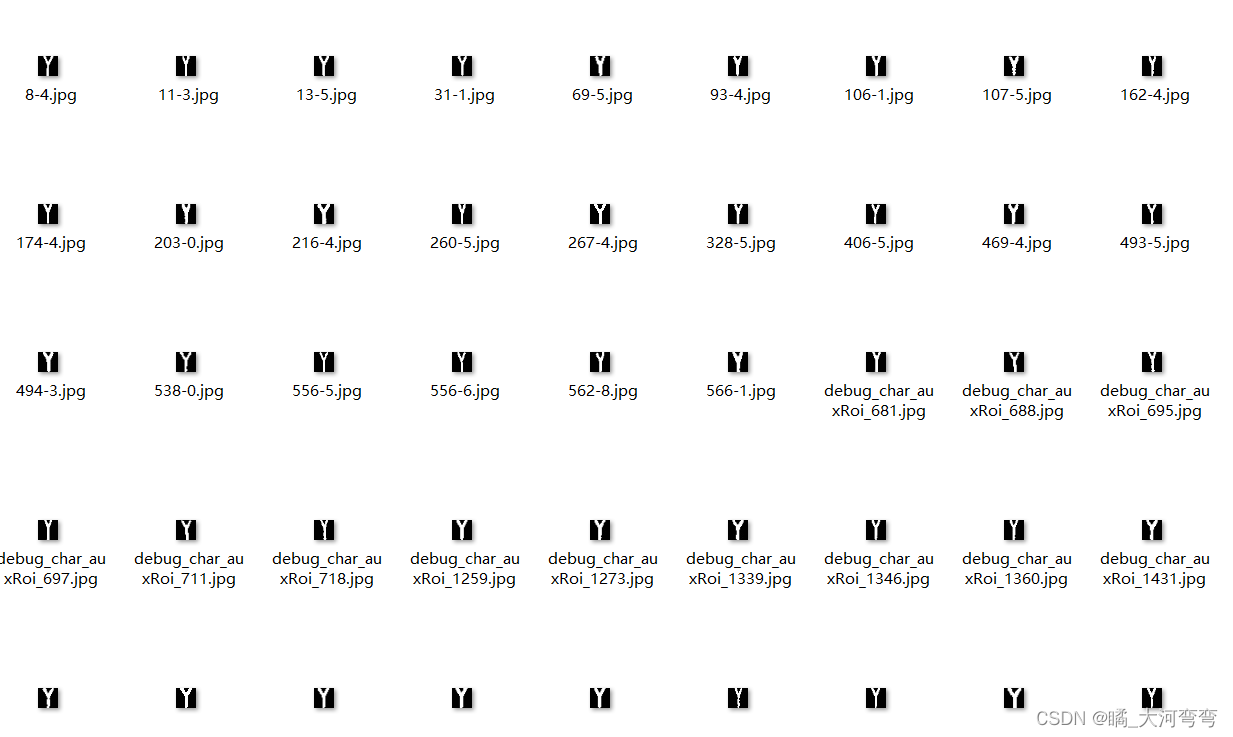

cnn_char_train种内容,每个文件夹种图片的数量大概在300张左右:

打开其中文件夹名为Y的可以看到:

也就是说cnn_char_train主要是训练cnn模型对字符的识别的。

而对于cnn_plate_train里面则包含两个文件夹:

其中has文件夹种是包含车牌的图片,一共有1916张:

而no种所包含的是不含车牌的文件,一共有3978张:

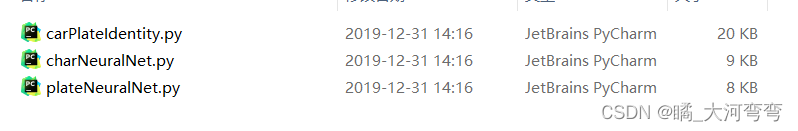

完整项目代码下载链接

下载链接

这个是有完整项目版的,会提供代码和上述的数据集,直接安装好所需的第三方库然后一件运行即可。是用opencv配合深度学习框架实现的功能,搭建的是CNN模型,模型较小,不用配置GPU,仅使用CPU就可以运行!:

车牌识别数据集2(目标检测算法,标准的标签格式)

下载链接

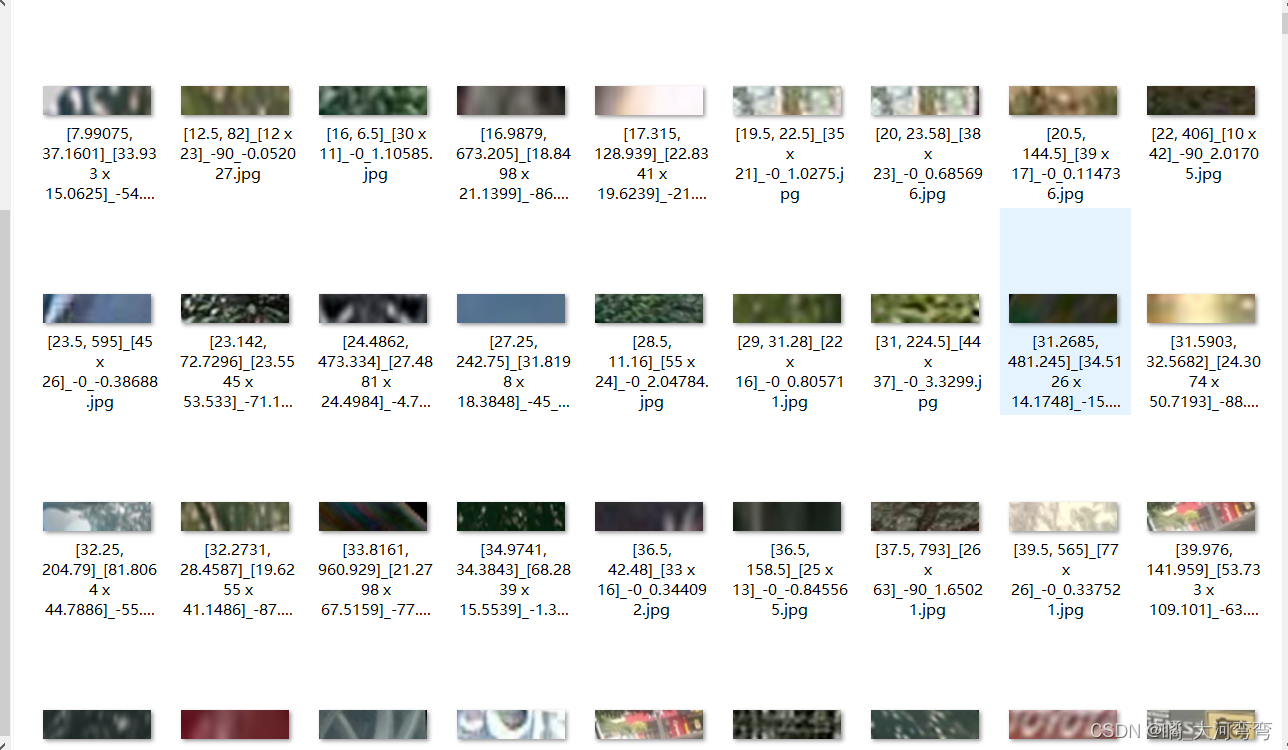

数据集如下所示,还是比较大的,受到1G限制,所以这里提供的是百度网盘下载链接。支持 1.单行蓝牌2.单行黄牌 3.新能源车牌 4.白色警用车牌 5.教练车牌 6.武警车牌 7.双层黄牌 8.双层白牌 9.使馆车牌10.港澳粤Z牌11.双层绿牌 12.民航车牌

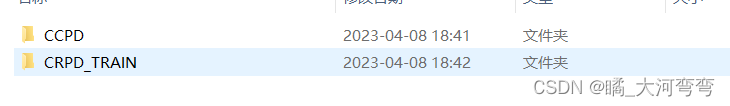

对于train_data的数据,则是从著名的CCPD和CRPD摘抄而出:

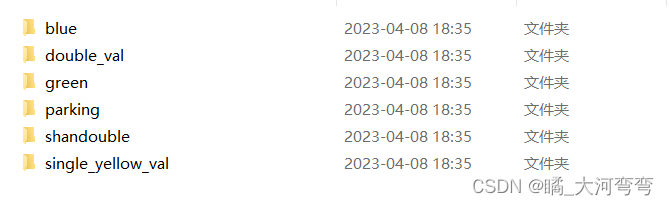

对于val-detect,其中每个文件就对应的不同的拍照啦,一共1W5个样本大概:

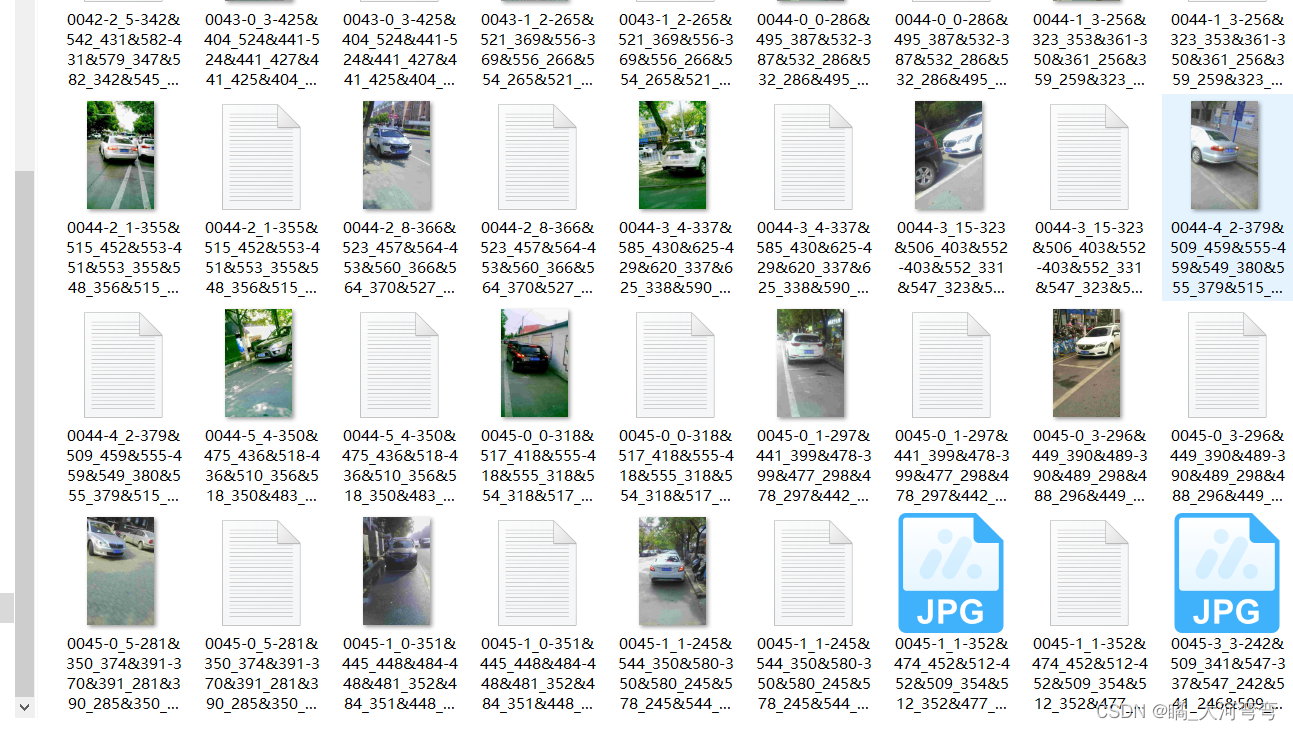

blue数据集部分内容:

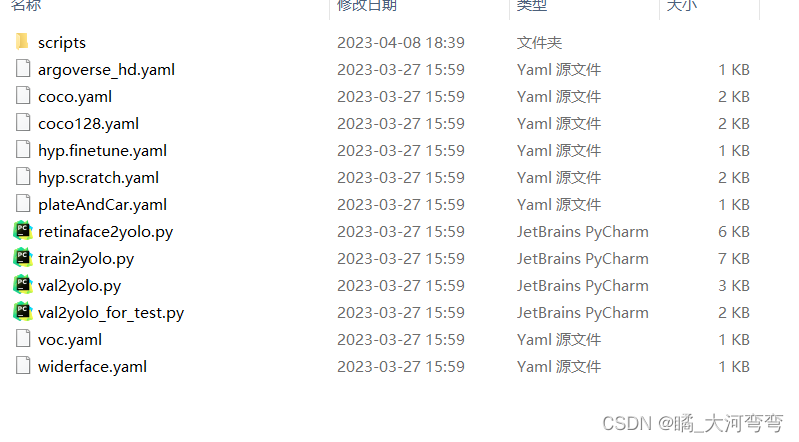

code文件夹包含的内容,其中脚本可以用来转换标签的格式:

完整项目代码下载链接

下载链接

这个是有完整项目版的,会提供代码和上述的数据集,直接安装好所需的第三方库然后一件运行即可。