机器学习 01

目录

一、机器学习

二、机器学习工作流程

2.1 获取数据

2.2 数据集

2.2.1 数据类型构成

2.2.2 数据分割

2.3 数据基本处理

2.4 特征工程

2.4.1什么是特征工程

2.4.2 为什么需要特征工程(Feature Engineering)

2.4.3 特征工程内容

2.5 机器学习

2.6 模型评估

2.7 拟合

2.7.1 欠拟合

2.7.2 过拟合

三、机器学习算法分类

3.1 监督学习

3.1.1 回归

3.1.2 分类

3.2 无监督学习

3.2.1 无监督学习 与 监督学习对比

3.3 半监督学习

3.4 强化学习

3.4.1 强化学习和监督学习的对比

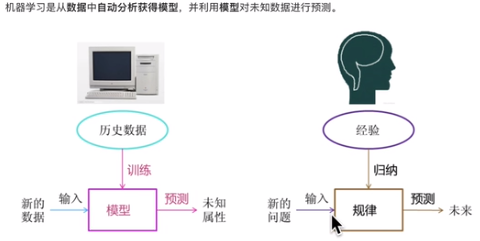

一、机器学习

机器学习是从数据中自动分析获得模型,并利用模型对未知数据进行预测

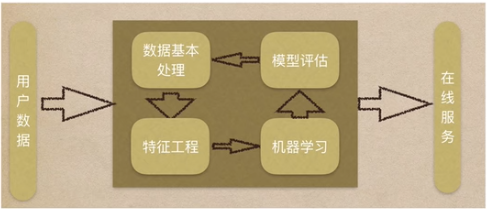

二、机器学习工作流程

机器学习工作流程总结

1、获取数据

2. 数据基本处理

3. 特征工程

4. 机器学习(模型训练)

5. 模型评估

结果达到要求,上线服务

没有达到要求,重新上面步骤

2.1 获取数据

归类:

2.2 数据集

在数据集中一般:

一行数据我们称为一个样本

一列数据我们成为一个特征

有些数据有目标值(标签值),有些数据没有目标值(如上表中,电影类型就是这个数据集的目标

值)

2.2.1 数据类型构成

数据类型一:特征值+目标值 (目标值是连续的和离散的)

数据类型二:只有特征值,没有目标值

2.2.2 数据分割

机器学习一般的数据集会划分为两个部分:

训练数据:用于训练,构建模型。

测试数据:在模型检验时使用,用于评估模型是否有效

划分比例:

训练集: 70% 80% 75%

测试集: 30%20% 25%

2.3 数据基本处理

即对数据进行缺失值、去除异常值等处理

2.4 特征工程

2.4.1什么是特征工程

特征工程是使用专业背景知识和技巧处理数据,使得特征能在机器学习算法上发挥更好的作用的过程。

意义:会直接影响机器学习的效果

2.4.2 为什么需要特征工程(Feature Engineering)

机器学习领域的大神Andrew Ng(吴恩达)老师说“Coming up with features is difficult, time-consuming,requires expert knowledge. "Applied machine learning" is basically feature engineering.

注:业界广泛流传:数据和特征决定了机器学习的上限,而模型和算法只是逼近这个上限而已。

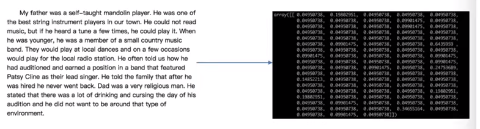

2.4.3 特征工程内容

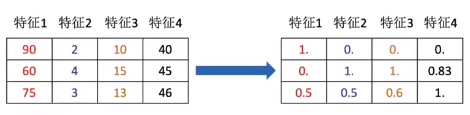

特征提取:将任意数据《如文本或图像)转换为可用于机器学习的数字特征

特征预处理:通过一些转换函数将特征数据转换成更加适合算法模型的特征数据过程

标准化/归一化

特征降维:指在某些限定条件下,降低随机变量(特征)个数,得到一组“不相关”主变量的过程

2.5 机器学习

选择合适的算法对模型进行训练

2.6 模型评估

对训练好的模型进行评估

模型评估是模型开发过程不可或缺的一部分。它有助于发现表达数据的最佳模型和所选模型将来工作的性能如何。

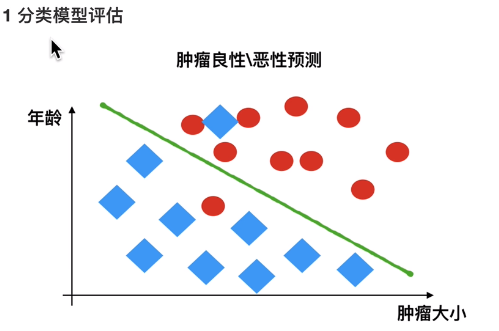

按照数据集的目标值不同,可以把模型评估分为分类模型评估和回归模型评估

2.6.1 分类模型评估

准确率: 预测正确的数占样本总数的比例。

其他评价指标: 精确率、召回率、F1-score、AUC指标等

2.6.2 回归模型评估

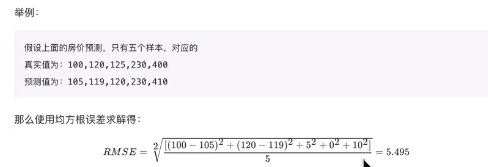

均方根误差 (Root Mean Squared Error,RMSE)

RMSE是一个衡量回归模型误差率的常用公式。不过,它仅能比较误差是相同单位的模型

其他评价指标:

相对平方误差 (Relative Squared Error,RSE)、

平均绝对误差(Mean AbsoluteError,MAE)、

相对绝对误差(Relative Absolute Error,RAE)

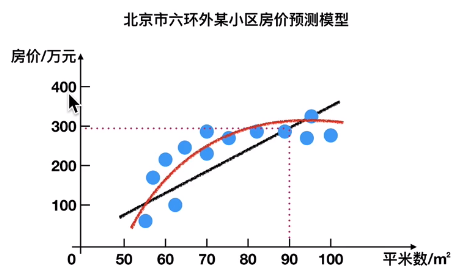

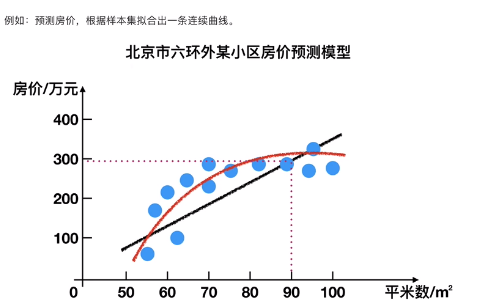

2.7 拟合

模型评估用于评价训练好的的模型的表现效果,其表现效果大致可以分为两类: 过拟合、欠拟合。

在训练过程中,你可能会遇到如下问题:

训练数据训练的很好啊,误差也不大,为什么在测试集上面有问题呢?

当算法在某个数据集当中出现这种情况,可能就出现了拟合问题。

2.7.1 欠拟合

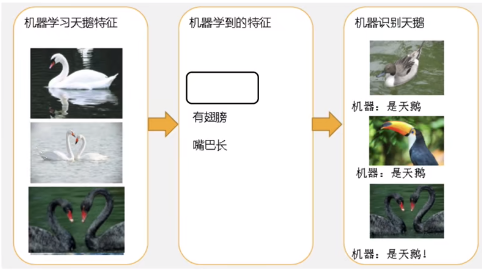

因为机器学习到的天鹅特征太少了,导致区分标准太粗糙,不能准确识别出天鹅。

欠拟合(under-fitting):模型学习的太过粗,连训练集中的样本数据特征关系都没有学出来

2.7.2 过拟合

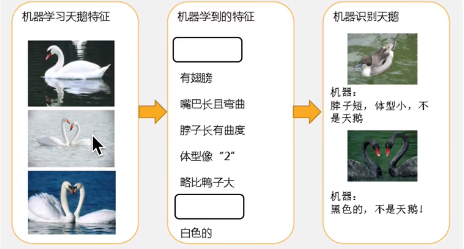

机器已经基本能区别天鹏和其他动物了。然后,很不巧已有的天鹅图片全是白天鹅的,于是机器经过学习后,会认为天鹅的羽毛都是白的,以后看到羽毛是黑的天鹅就会认为那不是天鹅。

过拟合 (over-fitting):所建的机器学习模型或者是深度学习模型在训练样本中表现得过于优越,导致在测试数据集中表现不佳。

上问题解答:

训练数据训练的很好啊,误差也不大,为什么在测试集上面有问题呢?

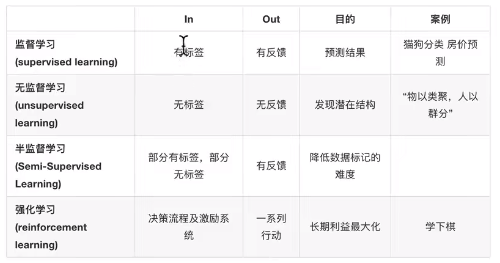

三、机器学习算法分类

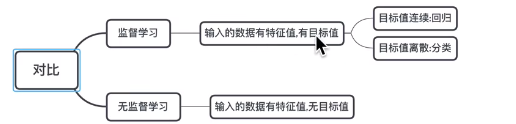

根据数据集组成不同,可以把机器学习算法分为

监督学习

无监督学习

半监督学习

强化学习

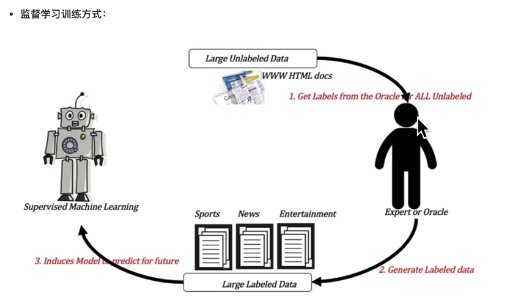

3.1 监督学习

定义: 输入数据是由输入特征值和目标值所组成。

函数的输出 可以是一个连续的值(称为回归)或是输出是有限个离散值 (称作分类)

3.1.1 回归

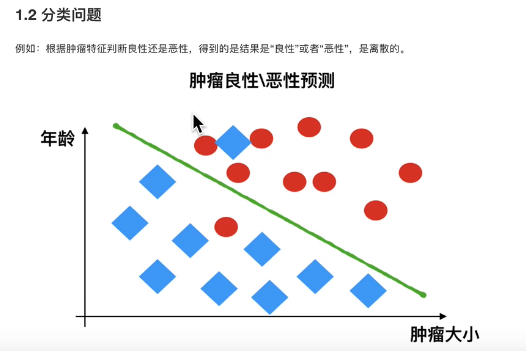

3.1.2 分类

区别:

欠拟合

学习到的东西太少。模型学习的太过相糙

过拟合

学习到的东西太多。学习到的特征多,不好泛化

3.2 无监督学习

定义: 输入数据是由输入特征值组成,没有目标值

1、输入数据没有被标记,也没有确定的结果。样本数据类别未知;

2、需要根据样本间的相似性对样本集进行类别划分;

根据有无帽子进行分类

3.2.1 无监督学习 与 监督学习对比

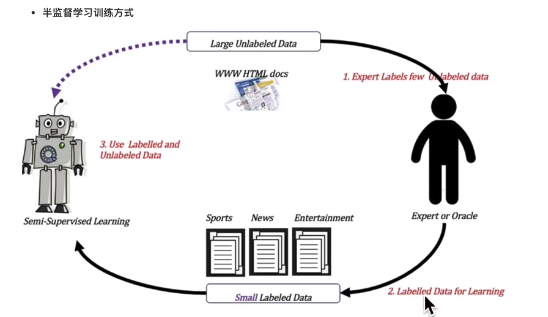

3.3 半监督学习

定义: 训练集同时包含有标记样本数据和未标记样本数据

区别: 1、标记数据量的多少 2、训练的模型有无用到未标记的数据

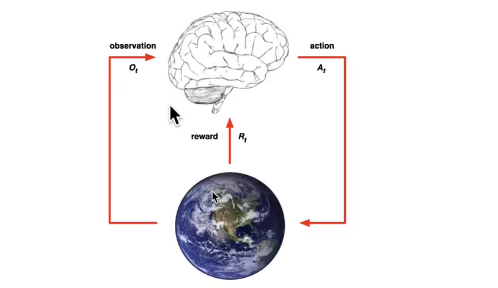

3.4 强化学习

定义: 实质是make decisions 问题,即自动进行决策,并且可以做连续决策

举例

小孩想要走路,但在这之前,他需要先站起来,站起来之后还要保持平衡,接下来还要先迈出一条腿,是左腿还是右腿,迈出一步后还要迈出下一步。

小孩就是 agent,他试图通过采取行动(即行走)来操纵环境行走的表面),并且从一个状态转变到另一个状态(即他走的每一步),当他完成任务的子任务即走了几步)时,孩子得到奖励《给巧克力吃),并且当他不能走路时,就不会给巧克力。

主要包含五个元素: agent,action,reward,environment,observation;

强化学习的目标: 为最大化reward之和,而不是单步reward

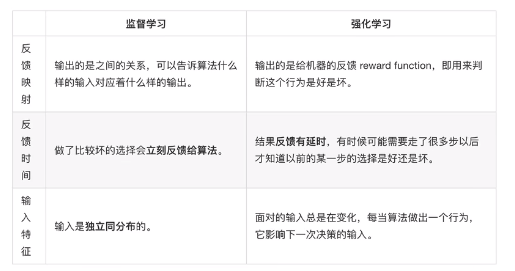

3.4.1 强化学习和监督学习的对比

1.独立同分布(i.i.d.)

在概率统计理论中,如果变量序列或者其他随机变量有相同的概率分布,并且互相独立,那么这些随机变量是独立同分布。

在西瓜书中解释是: 输入空间中的所有样本服从一个隐含未知的分布,训练数据所有样本都是独立地从这个分布上采样而得。

2.简单解释 一 独立、同分布、独立同分布

(1) 独立:每次抽样之间没有关系,不会相互影响举例:给一个般子,每次抛般子抛到几就是几,这是独立:如果我要抛般子两次之和大于8,那么第一次和第二次抛就不独立,因为第二次抛的结果和第一次相关。

(2) 同分布:每次抽样,样本服从同一个分布

举例:给一个股子,每次抛般子得到任意点数的概率都是六分之一,这个就是同分布

(3) 独立同分布:ld.,每次抽样之间独立而且同分布