2022年AI顶级论文 —生成模型之年(上)

CV - 计算机视觉 | ML - 机器学习 | RL - 强化学习 | NLP 自然语言处理

过去十年来,人工智能技术在持续提高和飞速发展,并不断冲击着人类的认知。

-

2016年,AlphaGo在围棋这一当时人们认为其复杂性很难被人工智能系统模拟的围棋挑战赛中战胜了世界冠军。

-

2017年,Google的Ashish Vaswani等人提出了 Transformer 深度学习新模型架构,奠定了当前大模型领域主流的算法架构基础。

-

2018年,谷歌提出了大规模预训练语言模型 BERT,该模型是基于 Transformer 的双向预训练模型,其模型参数首次超过了3亿(BERT-Large约有3.4个参数);同年,OpenAI提出了生成式预训练 Transformer 模型——GPT,大大地推动了自然语言处理领域的发展。

-

2018年,人工智能团队OpenAI Five战胜了世界顶级的Dota 2人类队伍,人工智能在复杂任务领域树立了一个新的里程碑;此后在2018年底,Google DeepMind团队提出的AlphaFold以前所未有的准确度成功预测了人类蛋白质结构,突破了人们对人工智能在生物学领域的应用的想象。

-

2019年,一种人工智能系统AlphaStar在2019年击败了世界顶级的StarCraft II人类选手,为人工智能在复杂任务领域的未来发展提供了有力的证明和支持。

-

2020年,随着OpenAI GPT-3模型(模型参数约1750亿)的问世,在众多自然语言处理任务中,人工智能均表现出超过人类平均水平的能力。

-

2021年1月,Google Brain提出了Switch Transformer模型,以高达1.6万亿的参数量成为史上首个万亿级语言模型;同年12月,谷歌还提出了1.2亿参数的通用稀疏模型GLaM,在多个小样本学习任务的性能超过GPT-3。

-

2022年2月,人工智能生成内容(AIGC)技术被《MIT Technology Review》评选为2022年全球突破性技术之一。同年8月,Stability AI开源了文字转图像的Stable Diffusion模型。也是在8月,艺术家杰森·艾伦(Jason Allen)利用AI工具制作的绘画作品《太空歌剧院》(Théâtre D’opéra Spatial),荣获美国科罗拉多州艺术博览会艺术竞赛冠军,相关技术于年底入选全球知名期刊《Science》年度科技突破(Breakthrough of the Year 2022)第2名。

今年,我们看到生成模型领域取得了重大进展。Stable Diffusion 🎨 创造超现实主义艺术。ChatGPT 💬 回答关于生命意义的问题。Galactica🧬 学习人类科学知识的同时也揭示了大型语言模型的局限性。本文涵盖了 2022 年 20 篇最具影响力的 AI 论文,但是这篇文章绝不是详尽无遗的,今年有很多很棒的论文——我最初想列出 10 篇论文,但最后却列出了 20 篇,其中涵盖不同主题的论文,例如生成模型(稳定扩散、ChatGPT)、AI 代理(MineDojo、Cicero)、3D 视觉(即时NGP、Block-NeRF)和新的state-of-the-基本 AI 任务中的艺术(YOLOv7,Whisper)。

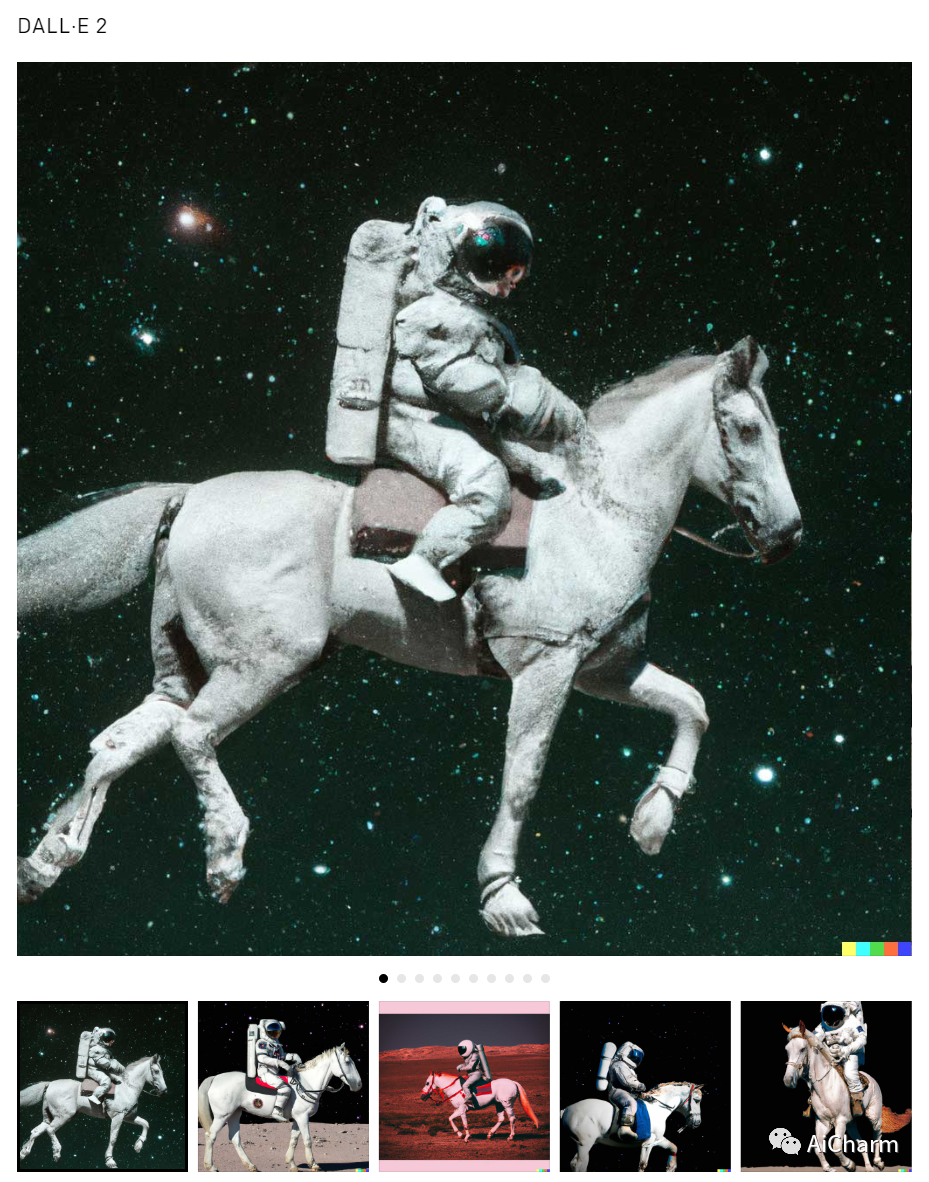

1. Hierarchical Text-Conditional Image Generation with CLIP Latents (DALL-E 2)

具有 CLIP 潜能的分层文本条件图像生成 (DALL-E 2)

作者:Aditya Ramesh, Prafulla Dhariwal, Alex Nichol, Casey Chu, Mark Chen

文章链接:https://arxiv.org/abs/2204.06125

简介

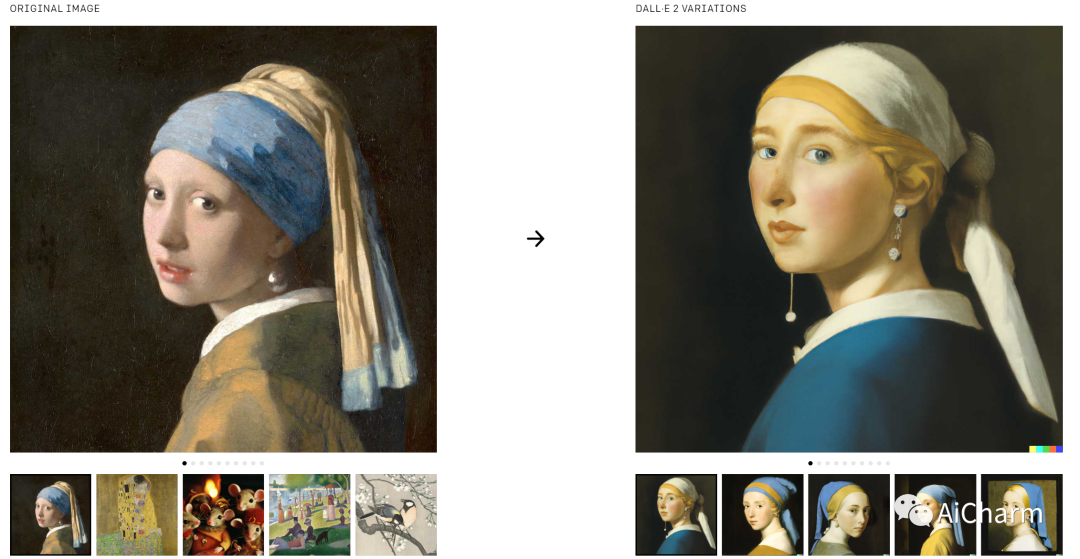

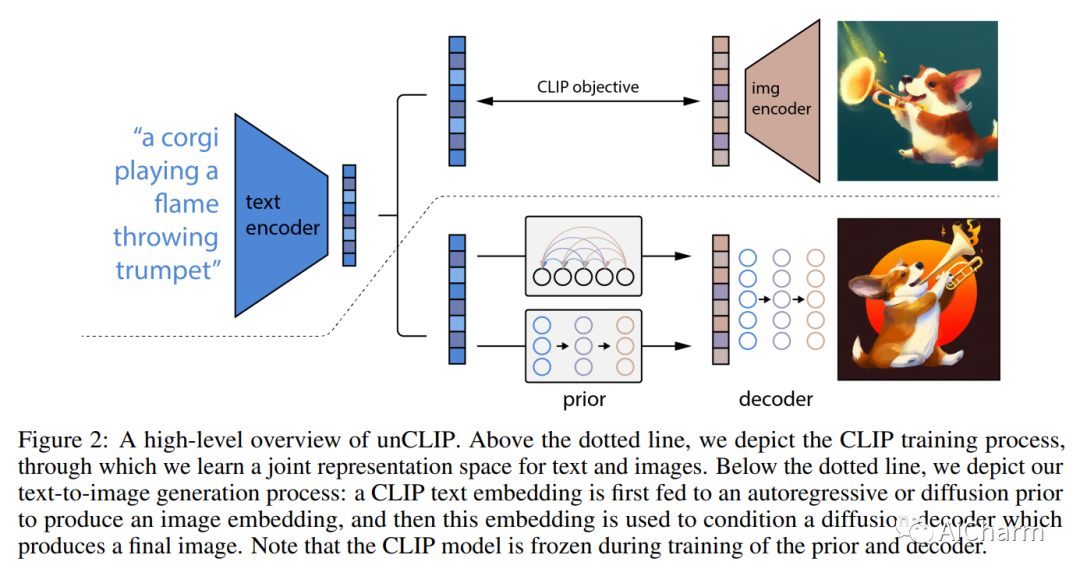

CLIP 等对比模型已被证明可以学习捕获语义和风格的图像的稳健表示。为了利用这些表示来生成图像,我们提出了一个两阶段模型:一个在给定文本标题的情况下生成 CLIP 图像嵌入的先验模型,以及一个以图像嵌入为条件生成图像的解码器。我们表明,显式生成图像表示可以提高图像多样性,同时将真实感和字幕相似性的损失降到最低。我们以图像表示为条件的解码器还可以生成图像的变体,同时保留其语义和风格,同时改变图像表示中不存在的非必要细节。此外,CLIP 的联合嵌入空间能够以零样本的方式进行语言引导的图像操作。我们对解码器使用扩散模型,并对先验模型使用自回归模型和扩散模型进行实验,发现后者在计算上更高效并产生更高质量的样本。

DALL-E 2 通过使用两阶段模型提高了 DALL-E 文本到图像生成功能的真实性、多样性和计算效率。DALL-E 2 首先在给定文本标题的情况下生成 CLIP 图像嵌入,然后使用基于扩散的解码器生成以图像嵌入为条件的图像。

2. High-Resolution Image Synthesis with Latent Diffusion Models (Stable Diffusion)

具有潜在扩散模型的高分辨率图像合成(稳定扩散)

作者:Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, Björn Ommer

文章链接:https://arxiv.org/abs/2112.10752

简介

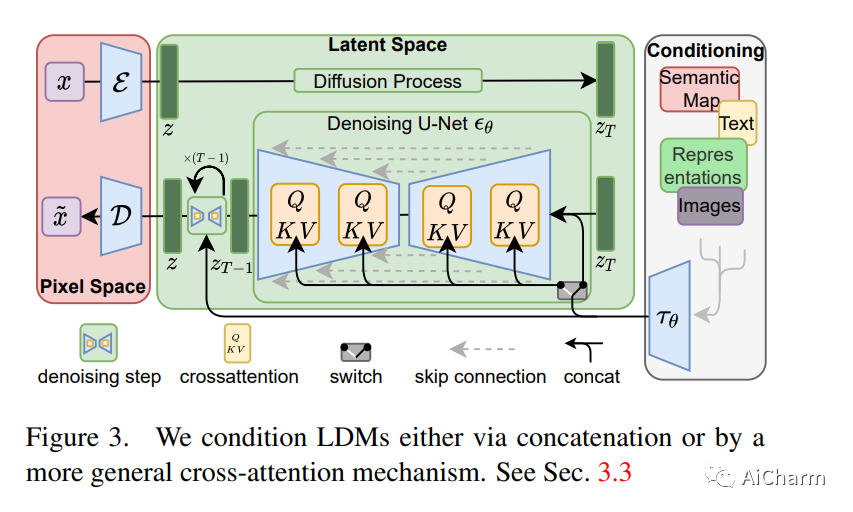

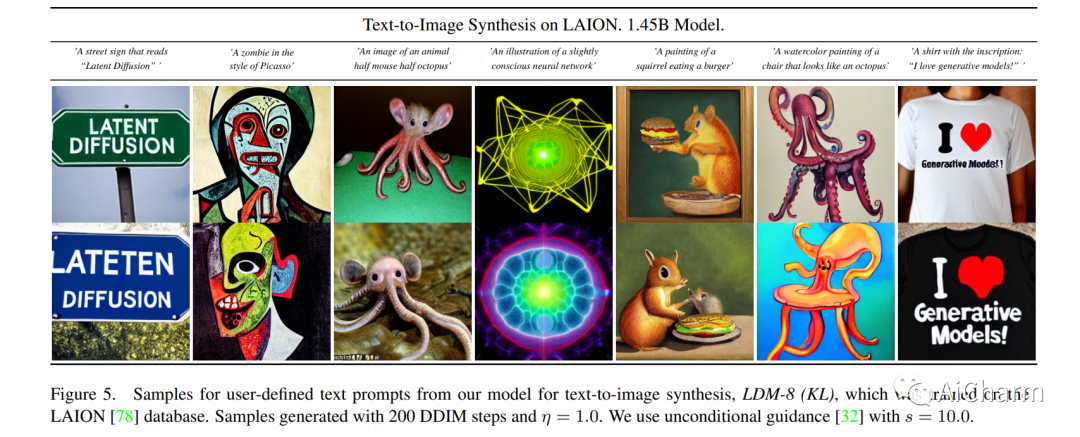

通过将图像形成过程分解为去噪自动编码器的顺序应用,扩散模型 (DM) 在图像数据及其他数据上实现了最先进的合成结果。此外,他们的公式允许一种引导机制来控制图像生成过程而无需重新训练。然而,由于这些模型通常直接在像素空间中运行,因此强大的 DM 的优化通常会消耗数百个 GPU 天,并且由于顺序评估,推理非常昂贵。为了在有限的计算资源上启用 DM 训练,同时保持其质量和灵活性,我们将它们应用于强大的预训练自动编码器的潜在空间。与以前的工作相比,在这种表示上训练扩散模型首次允许在复杂性降低和细节保留之间达到接近最佳点,从而大大提高了视觉保真度。通过在模型架构中引入交叉注意力层,我们将扩散模型转变为强大而灵活的生成器,用于一般条件输入(例如文本或边界框),并且以卷积方式进行高分辨率合成成为可能。我们的潜在扩散模型 (LDM) 实现了图像修复的最新技术水平和在各种任务上的极具竞争力的性能,包括无条件图像生成、语义场景合成和超分辨率,同时与基于像素的 DM 相比显着降低了计算要求。

Stable Diffusion 使用扩散概率模型实现程式化和逼真的文本到图像生成。凭借其开源的模型和权重,Stable Diffusion 启发了无数文本到图像的社区和初创公司。

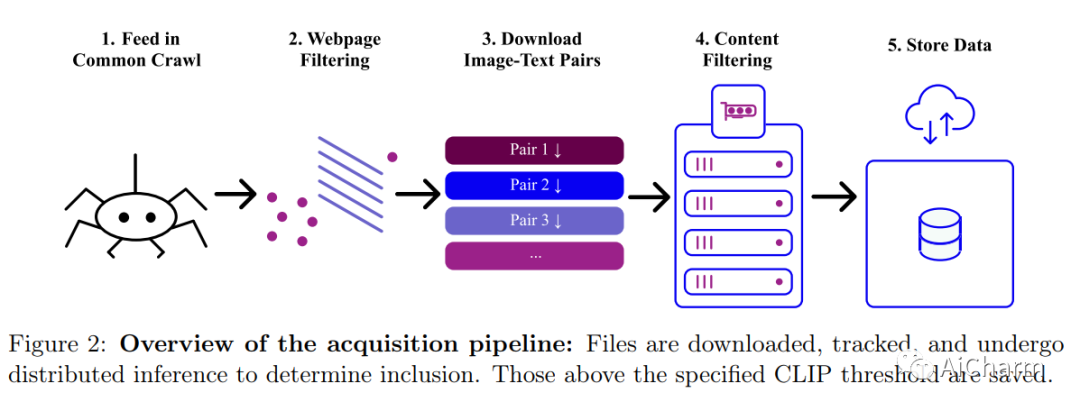

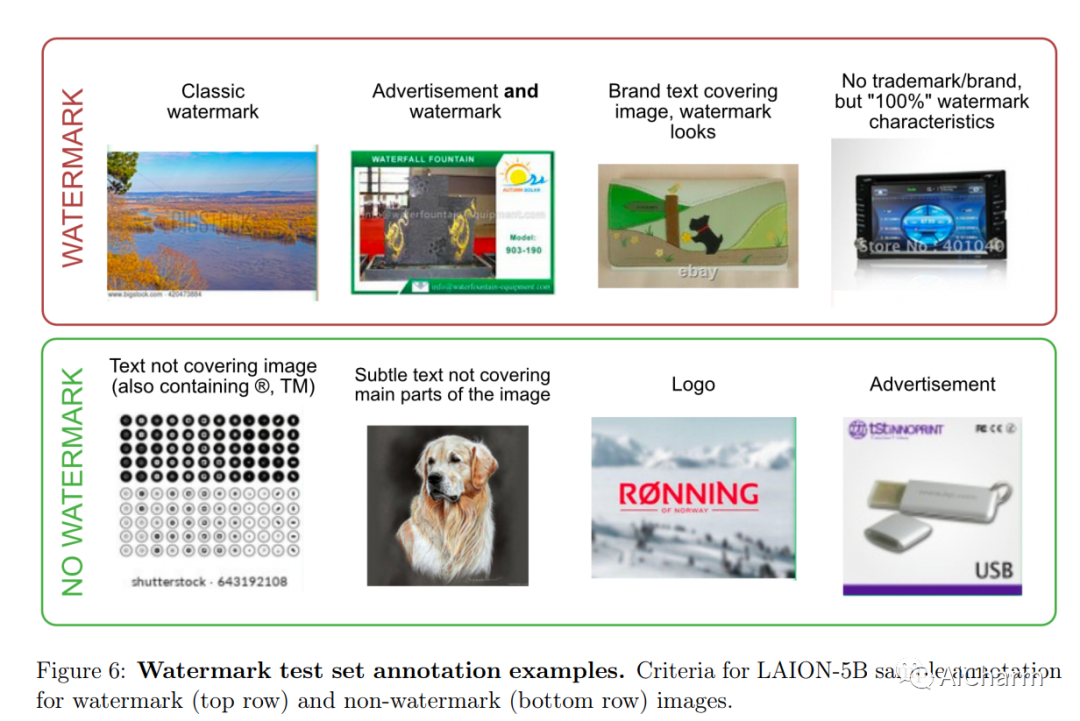

3. LAION-5B: An Open Large-Scale Dataset for Training Next Generation Image-Text Models

LAION-5B:用于训练下一代图像文本模型的开放式大规模数据集

作者:Christoph Schuhmann, Romain Beaumont, Richard Vencu, Cade Gordon, Ross Wightman, Mehdi Cherti, Theo Coombes, Aarush Katta, Clayton Mullis, Mitchell Wortsman, Patrick Schramowski, Srivatsa Kundurthy, Katherine Crowson, Ludwig Schmidt, Robert Kaczmarczyk, Jenia Jitsev

文章链接:https://arxiv.org/abs/2210.08402

简介

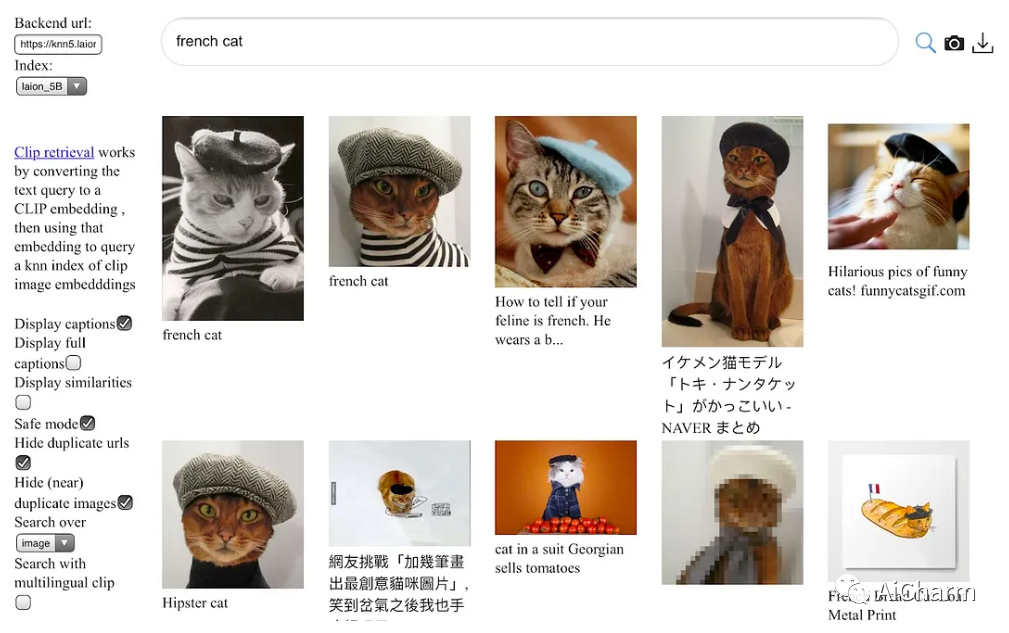

CLIP 和 DALL-E 等开创性的语言视觉架构证明了在大量嘈杂的图像文本数据上进行训练的实用性,而不依赖于标准视觉单峰监督学习中使用的昂贵的准确标签。由此产生的模型显示出强大的文本引导图像生成和传输到下游任务的能力,同时在零样本分类方面表现出色,具有值得注意的分布外鲁棒性。此后,ALIGN、BASIC、GLIDE、Flamingo 和 Imagen 等大型语言视觉模型有了进一步的改进。研究此类模型的训练和功能需要包含数十亿图像文本对的数据集。到目前为止,还没有这种规模的数据集可供更广泛的研究社区公开使用。为了解决这个问题并使大规模多模态模型的研究民主化,我们提出了 LAION-5B——一个由 58.5 亿个 CLIP 过滤的图像文本对组成的数据集,其中 2.32B 包含英语。我们使用数据集展示了 CLIP、GLIDE 和 Stable Diffusion 等基础模型的成功复制和微调,并讨论了使用这种规模的公开可用数据集启用的进一步实验。此外,我们还提供了几个最近邻索引、用于数据集探索和子集生成的改进 Web 界面,以及水印、NSFW 和有毒内容检测的检测分数。

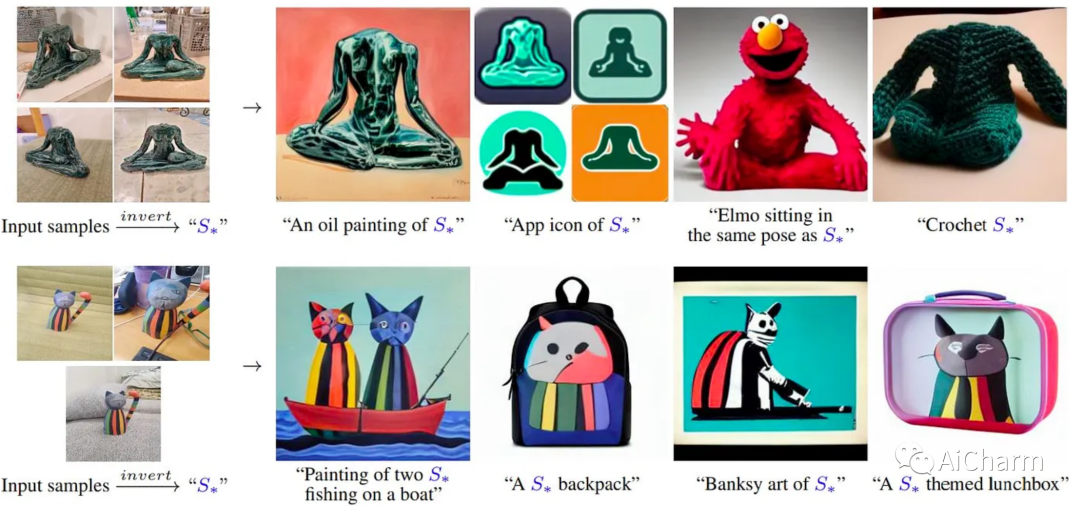

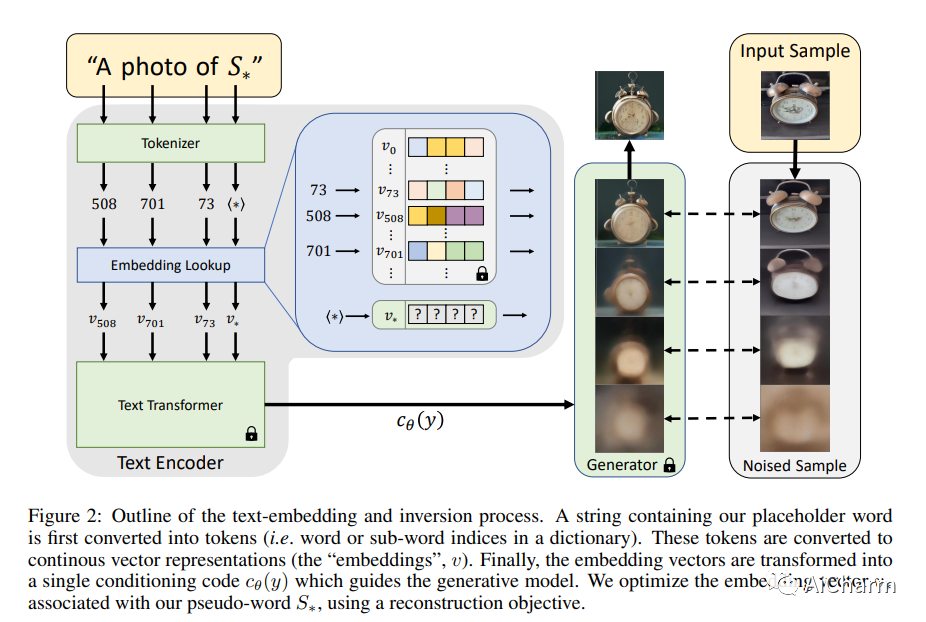

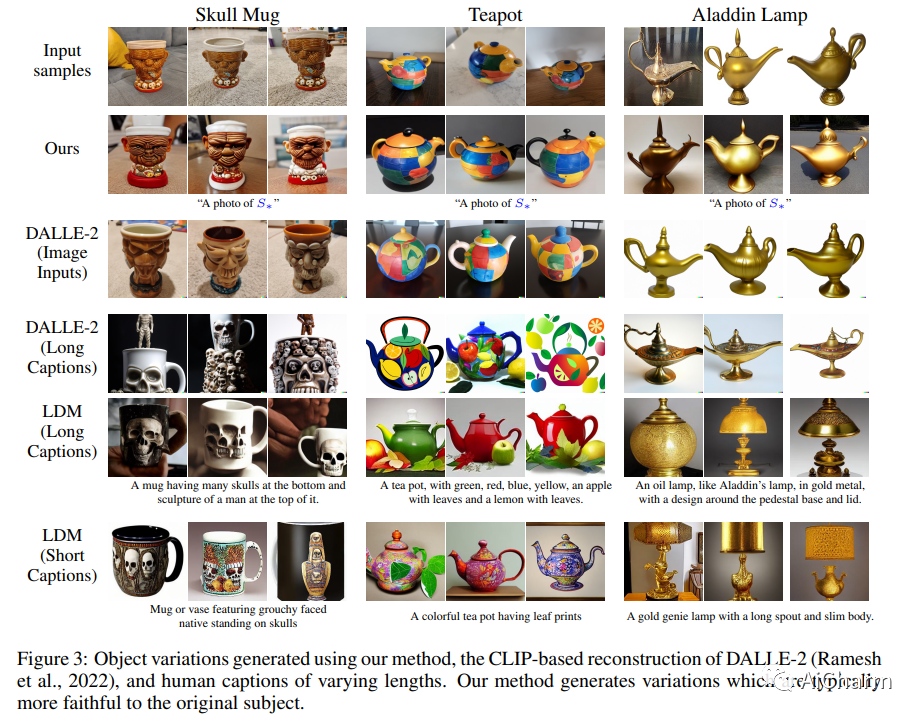

4. An Image is Worth One Word: Personalizing Text-to-Image Generation using Textual Inversion

一张图片胜过一个字:使用文本反转个性化文本到图像的生成

作者:Rinon Gal, Yuval Alaluf, Yuval Atzmon, Or Patashnik, Amit H. Bermano, Gal Chechik, Daniel Cohen-Or

文章链接:https://arxiv.org/abs/2208.01618

简介

文本到图像模型提供了前所未有的自由度,可以通过自然语言来指导创作。然而,尚不清楚如何行使这种自由来生成特定独特概念的图像、修改它们的外观或将它们组合成新角色和新场景。换句话说,我们问:我们如何使用语言引导模型将我们的猫变成一幅画,或者根据我们最喜欢的玩具想象一个新产品?在这里,我们提出了一种允许这种创造性自由的简单方法。仅使用用户提供的概念(如对象或样式)的 3-5 张图像,我们学习通过冻结文本到图像模型的嵌入空间中的新“词”来表示它。这些“词”可以组合成自然语言的句子,以直观的方式指导个性化创作。值得注意的是,我们发现有证据表明单个词嵌入足以捕获独特而多样的概念。我们将我们的方法与广泛的基线进行比较,并证明它可以更忠实地描绘一系列应用程序和任务中的概念。

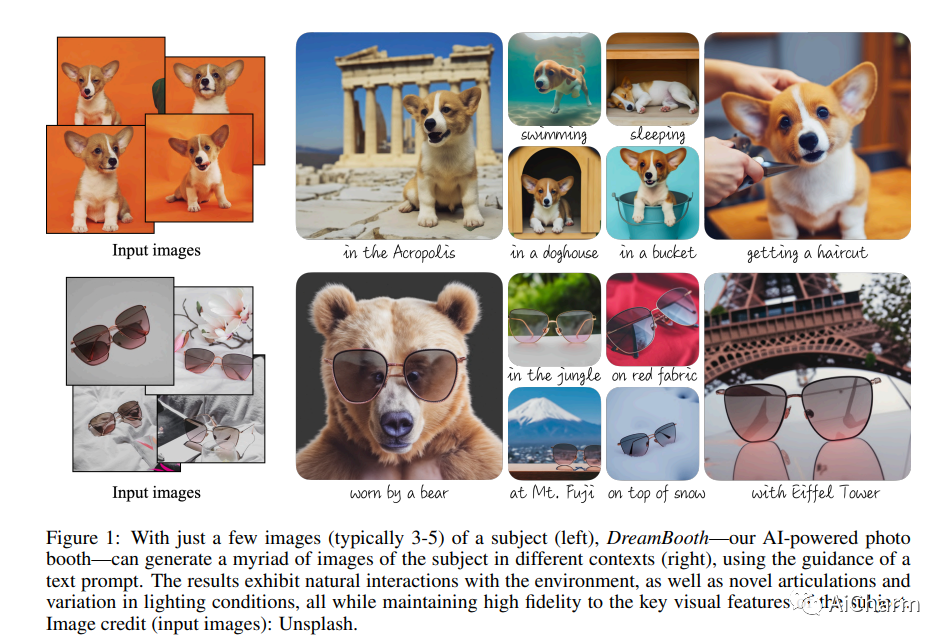

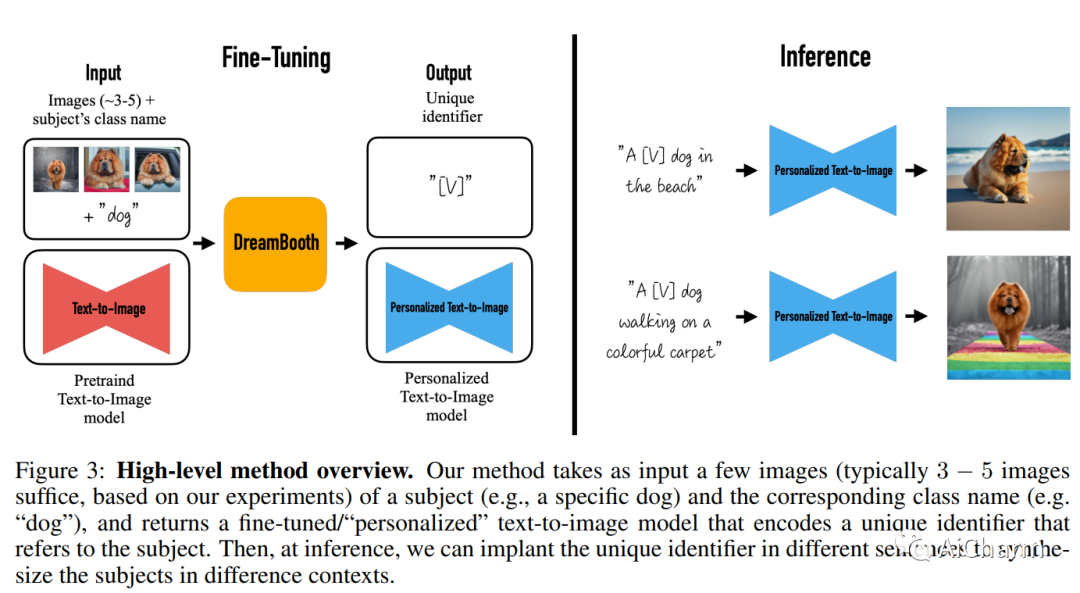

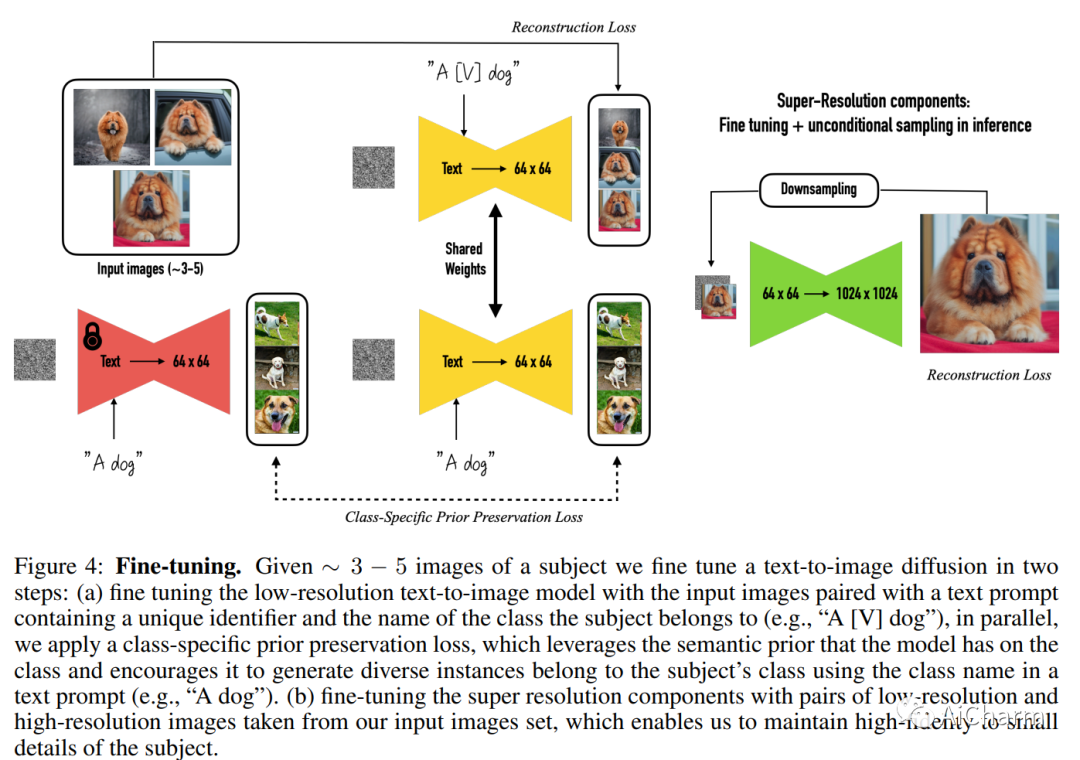

5. DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation

DreamBooth:为主题驱动生成微调文本到图像扩散模型

作者:Nataniel Ruiz, Yuanzhen Li, Varun Jampani, Yael Pritch, Michael Rubinstein, Kfir Aberman

文章链接:https://arxiv.org/abs/2208.12242

简介

大型文本到图像模型实现了 AI 发展的显着飞跃,能够根据给定的文本提示合成高质量和多样化的图像。然而,这些模型缺乏在给定参考集中模仿对象外观以及在不同上下文中合成它们的新颖演绎的能力。在这项工作中,我们提出了一种新的文本到图像扩散模型的“个性化”方法(根据用户的需求对其进行专门化)。给定主题的几张图像作为输入,我们微调预训练的文本到图像模型(Imagen,尽管我们的方法不限于特定模型),以便它学会将唯一标识符与该特定主题绑定.一旦主体被嵌入到模型的输出域中,唯一标识符就可以用于合成主体在不同场景中的全新逼真图像。通过利用模型中嵌入的语义先验和新的自生类特定先验保存损失,我们的技术能够在参考图像中没有出现的不同场景、姿势、视图和光照条件下合成主体。我们将我们的技术应用于几个以前无懈可击的任务,包括主题重新上下文化、文本引导视图合成、外观修改和艺术渲染(同时保留主题的关键特征)。

DreamBooth 是一种微调文本到图像模型以了解特定主题的技术,以便生成包含该主题的新图像。例如,用户可以让文本到图像模型了解他们的小狗,并生成他们的小狗理发的新图像。

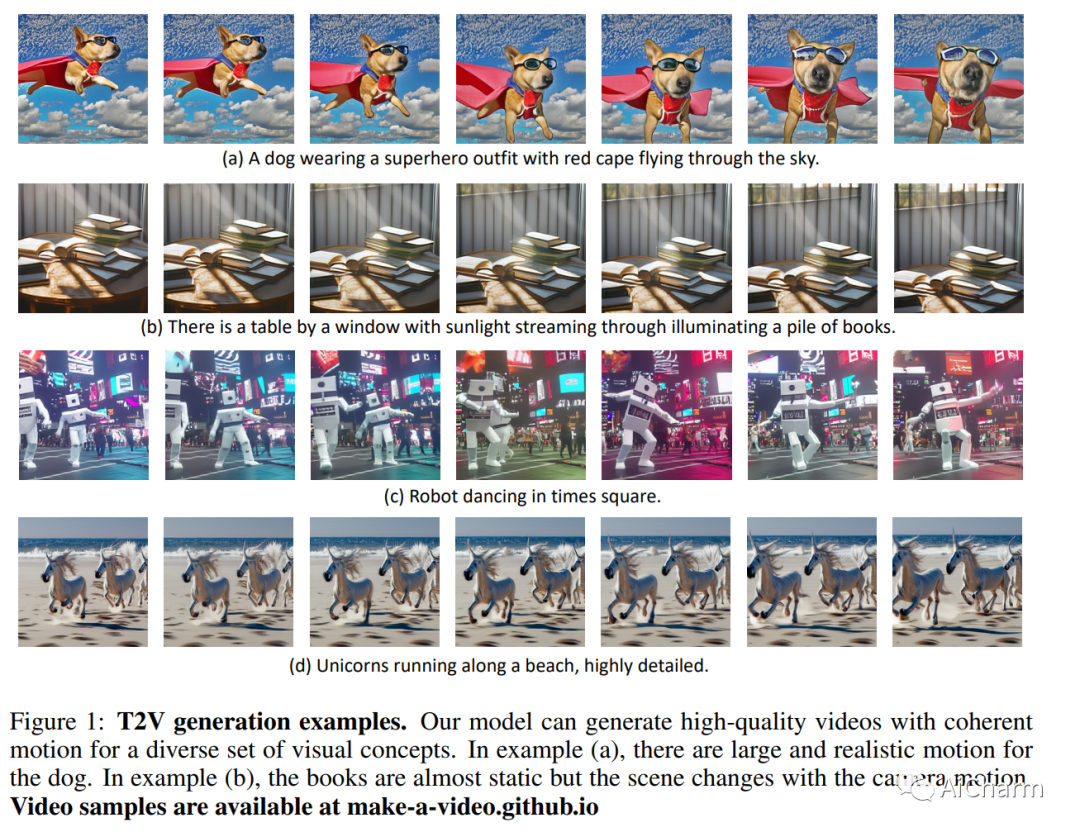

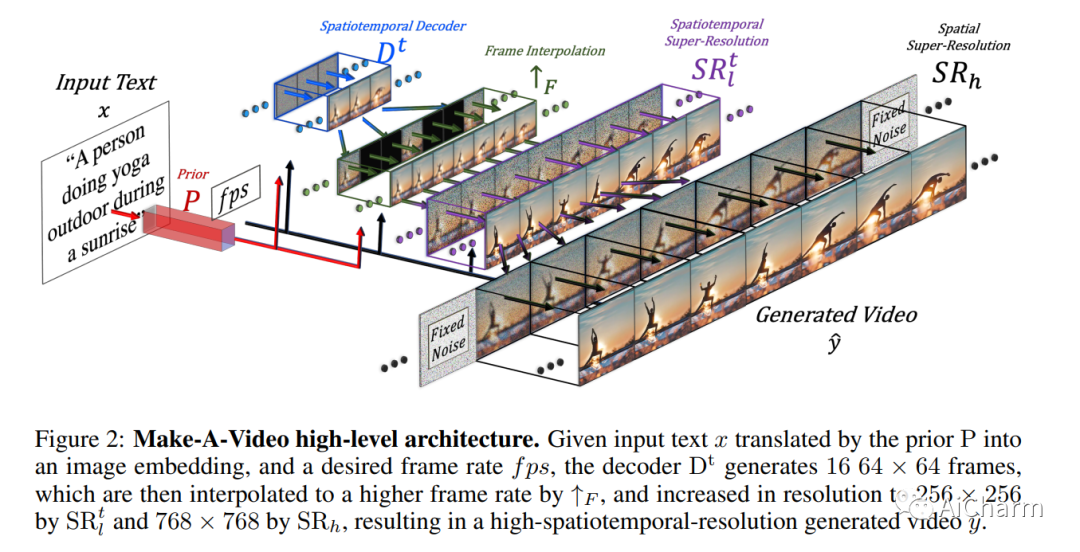

6. Make-A-Video: Text-to-Video Generation without Text-Video Data

制作视频:没有文本视频数据的文本到视频生成

作者:Uriel Singer, Adam Polyak, Thomas Hayes, Xi Yin, Jie An, Songyang Zhang, Qiyuan Hu, Harry Yang, Oron Ashual, Oran Gafni, Devi Parikh, Sonal Gupta, Yaniv Taigman

文章链接:https://arxiv.org/abs/2209.14792

简介

我们提出制作视频——一种直接将文本到图像 (T2I) 生成的巨大最新进展转化为文本到视频 (T2V) 的方法。我们的直觉很简单:从成对的文本图像数据中了解世界是什么样子以及它是如何描述的,并从无监督的视频片段中了解世界是如何移动的。Make-A-Video 具有三个优点:(1)它加速了 T2V 模型的训练(它不需要从头开始学习视觉和多模态表示),(2)它不需要成对的文本视频数据,以及(3 ) 生成的视频继承了当今图像生成模型的广泛性(审美多样性、奇幻描绘等)。我们设计了一种简单而有效的方法来构建具有新颖有效的时空模块的 T2I 模型。首先,我们分解完整的时间 U-Net 和注意力张量,并在空间和时间上对它们进行近似。其次,我们设计了一个时空管道来生成高分辨率和帧率视频,其中包含一个视频解码器、插值模型和两个超分辨率模型,可以实现除 T2V 之外的各种应用。在空间和时间分辨率、对文本的忠实度和质量的所有方面,Make-A-Video 都设置了文本到视频生成的最新技术水平,这由定性和定量指标决定。

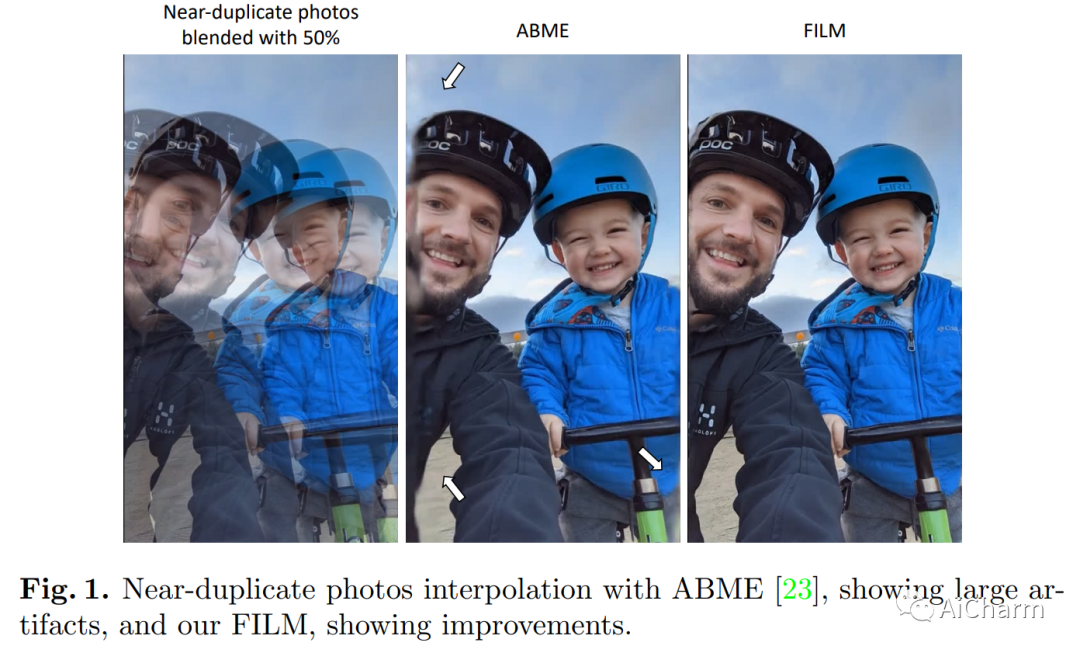

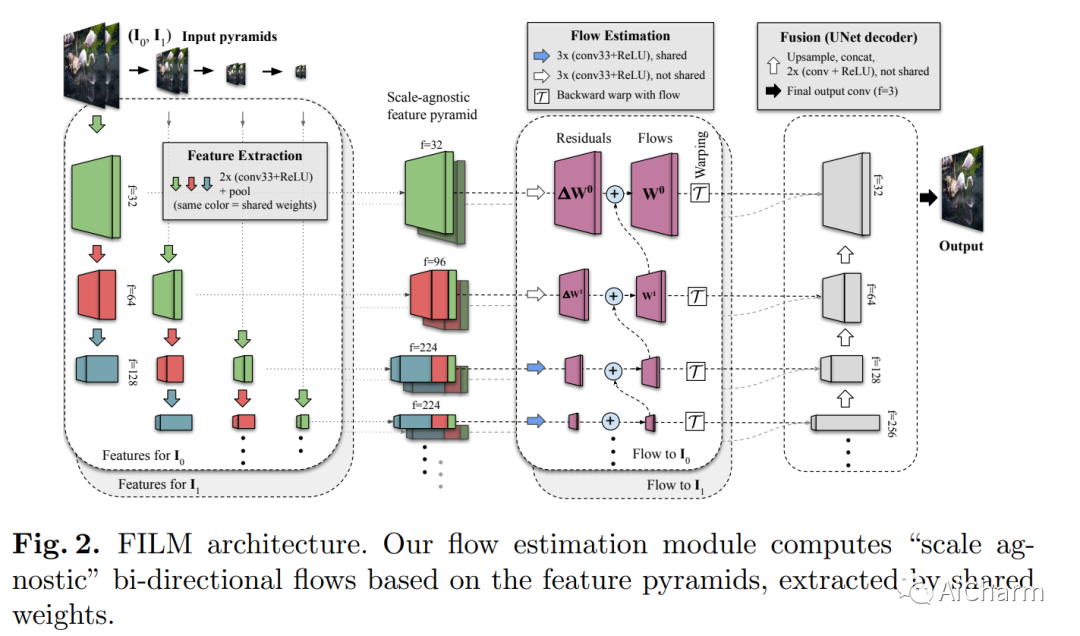

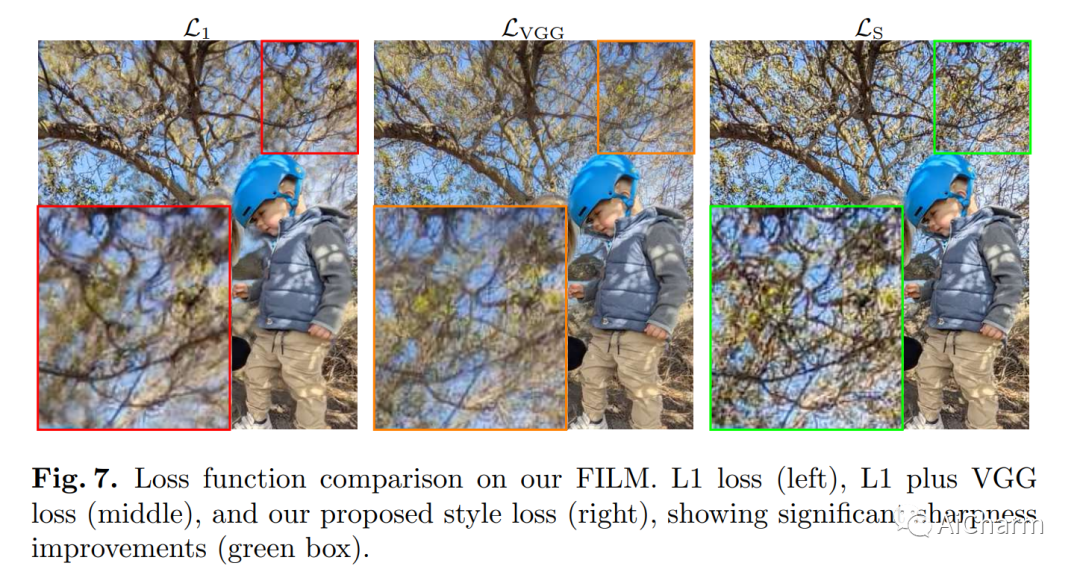

7. FILM: Frame Interpolation for Large Motion

电影:大运动的帧插值

作者:Fitsum Reda, Janne Kontkanen, Eric Tabellion, Deqing Sun, Caroline Pantofaru, Brian Curless

文章链接:https://arxiv.org/abs/2202.04901

简介

我们提出了一种帧插值算法,该算法从具有大中间运动的两个输入图像合成多个中间帧。最近的方法使用多个网络来估计光流或深度,并使用一个专用于帧合成的单独网络。这通常很复杂,需要稀缺的光流或深度地面实况。在这项工作中,我们提出了一个单一的统一网络,以多尺度特征提取器为特征,该特征提取器在所有尺度上共享权重,并且可以单独从帧进行训练。为了合成清晰悦目的帧,我们建议使用衡量特征图之间相关性差异的 Gram 矩阵损失来优化我们的网络。我们的方法在 Xiph 大运动基准测试中优于最先进的方法。与使用感知损失的方法相比,我们在 Vimeo-90K、Middlebury 和 UCF101 上也取得了更高的分数。我们研究了权重共享和使用增加运动范围的数据集进行训练的效果。最后,我们展示了我们的模型在具有挑战性的近乎重复的照片数据集上合成高质量和时间连贯视频的有效性。此 https URL 提供代码和预训练模型。