安装Scala和Spark

Scala安装

解压并修改名称

[root@guo147 install]# tar -zxvf scala-2.12.10.tgz -C ../soft/

[root@guo147 soft]# mv scala-2.12.10/ scala212

配置Scala环境变量

[root@guo147 soft]# vim /etc/profile

添加内容如下:

#SCALA_HOME

export SCALA_HOME=/opt/soft/scala212

export PATH=$PATH:$SCALA_HOME/bin

生效环境变量

[root@guo147 soft]# source /etc/profile

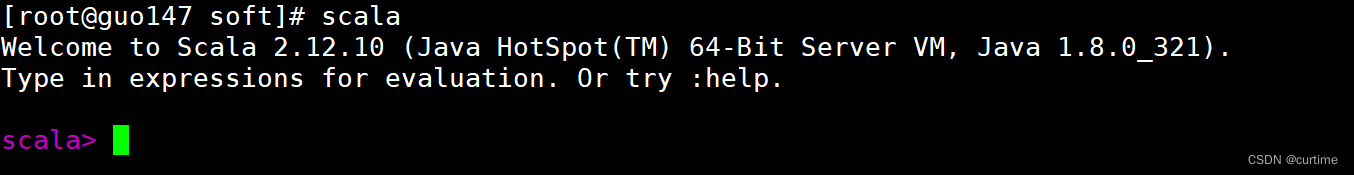

查看Scala是否安装成功

[root@guo147 soft]# scala -version

出现版本号安装成功

Spark安装

解压并修改名称

[root@guo147 install]# tar -zxvf spark-3.1.2-bin-hadoop3.2.tgz -C ../soft/

[root@guo147 soft]# mv spark-3.1.2-bin-hadoop3.2/ spark312

配置spark-env.sh文件

拷贝并配置

[root@guo147 conf]# cp spark-env.sh.template spark-env.sh

[root@guo147 conf]# vim spark-env.sh

添加内容如下

export SCALA_HOME=/opt/soft/scala212

export JAVA_HOME=/opt/soft/jdk180

export SPARK_HOME=/opt/soft/spark312

export HADOOP_INSTALL=/opt/soft/hadoop313

export HADOOP_CONF_DIR=$HADOOP_INSTALL/etc/hadoop

export SPARK_MASTER_IP=guo146

export SPARK_DRIVER_MEMORY=2G

export SPARK_LOCAL_DIRS=/opt/soft/spark312

export SPARK_EXECUTOR_MEMORY=2G

配置Spark环境变量

[root@guo147 soft]# vim /etc/profile

添加内容如下:

#SPARK_HOME

export SPARK_HOME=/opt/soft/spark312

export PATH=$PATH:$SPARK_HOME/bin

生效环境变量

[root@guo147 soft]# source /etc/profile

若出现以下界面,则代表连接成功

[root@guo147 conf]# spark-shell