基于 pytorch 的手写 transformer + tokenizer

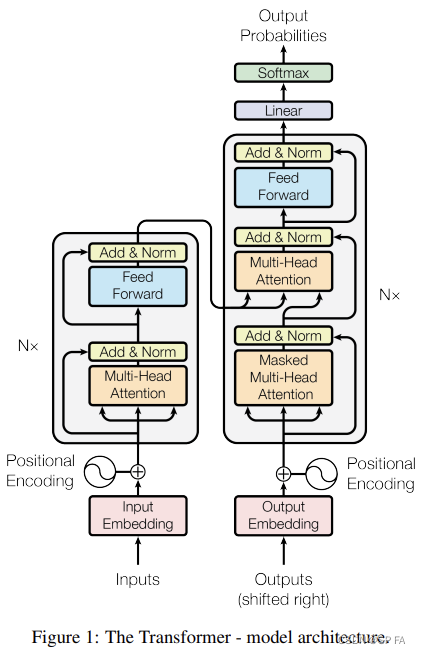

先放出 transformer 的整体结构图,以便复习,接下来就一个模块一个模块的实现它。

1. Embedding

Embedding 部分主要由两部分组成,即 Input Embedding 和 Positional Encoding,位置编码记录了每一个词出现的位置。通过加入位置编码可以提高模型的准确率,因为同一个词出现在不同位置可能代表了不同意思,这直接影响了最终的结果,所以要考虑位置因素。

位置编码公式:

P E ( p o s , 2 i ) =