d2l 注意力评分函数 --附加mask_softmax讲解

本章节tensor处理操作也不少,逐个讲解下:

目录

1.mask_softmax

1.1探索源码d2l.sequence_mask

2.加性注意力

3.缩放注意力

1.mask_softmax

dim=-1表示对最后一个维度进行softmax

.dim()返回的是维度数

对于需要mask的数,要用绝对值非常大的负数替换,不能用0,因为0进行softmax时exp=1,返回值不会约等于0.

#@save

def masked_softmax(X, valid_lens):"""通过在最后⼀个轴上掩蔽元素来执⾏softmax操作"""# X:3D张量,valid_lens:1D或2D张量if valid_lens is None:return nn.functional.softmax(X, dim=-1)else:shape = X.shapeif valid_lens.dim() == 1:valid_lens = torch.repeat_interleave(valid_lens, shape[1])else:valid_lens = valid_lens.reshape(-1)# 最后⼀轴上被掩蔽的元素使⽤⼀个⾮常⼤的负值替换,从⽽其softmax输出为0X = d2l.sequence_mask(X.reshape(-1, shape[-1]), valid_lens,value=-1e6)return nn.functional.softmax(X.reshape(shape), dim=-1)验证:2个2×4矩阵样本,指定两个样本的有效长度分别为2和3

masked_softmax(torch.rand(2, 2, 4), torch.tensor([2, 3]))'''

tensor([[[0.4265, 0.5735, 0.0000, 0.0000],[0.6215, 0.3785, 0.0000, 0.0000]],[[0.2043, 0.3346, 0.4611, 0.0000],[0.3598, 0.2352, 0.4050, 0.0000]]])

'''指定二维张量,len中的形状为(2,2),第一个表示每个指哪个样本,第二个维度里面的表示指定每个样本的每一行的有效长度

masked_softmax(torch.rand(2, 2, 4), torch.tensor([[1, 3], [2, 4]]))'''

tensor([[[1.0000, 0.0000, 0.0000, 0.0000],[0.4087, 0.3961, 0.1952, 0.0000]],[[0.6028, 0.3972, 0.0000, 0.0000],[0.1992, 0.2031, 0.3061, 0.2915]]])

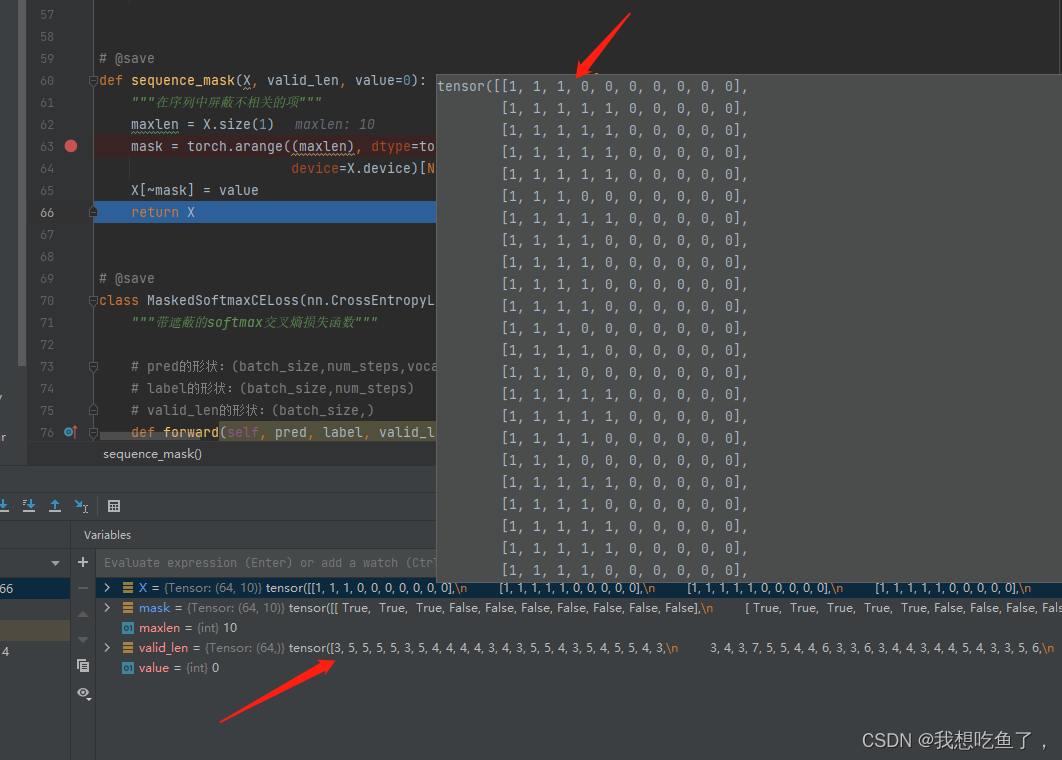

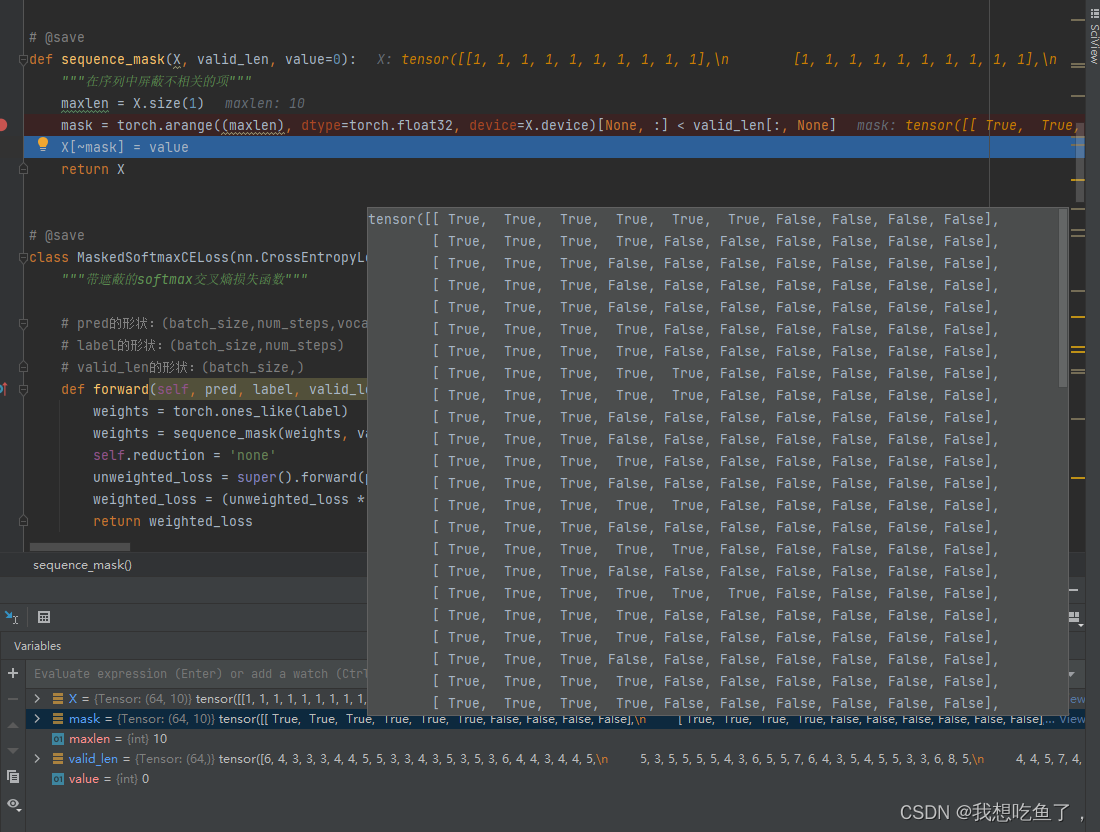

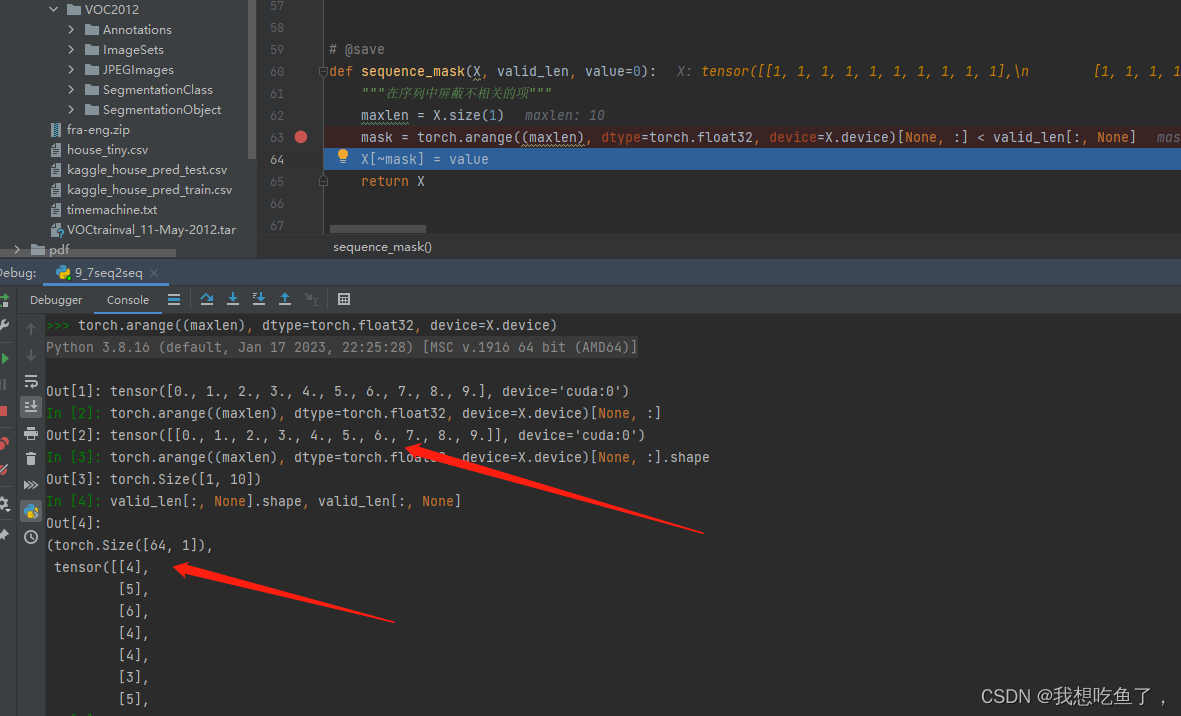

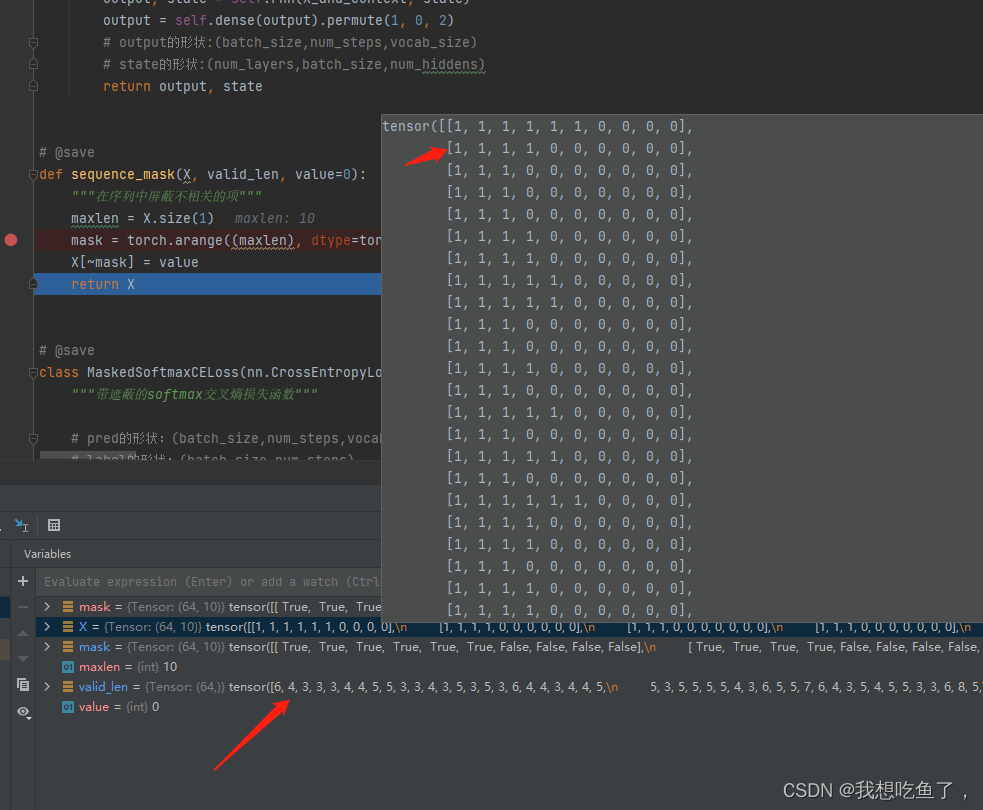

'''1.1探索源码d2l.sequence_mask

庐山真面目:

# @save

def sequence_mask(X, valid_len, value=0):"""在序列中屏蔽不相关的项"""maxlen = X.size(1)mask = torch.arange((maxlen), dtype=torch.float32, device=X.device)[None, :] < valid_len[:, None]X[~mask] = valuereturn X

送进去X(bs,T)与valid_len(bs),返回的是(bs,T),且valid_len后全为0

将两项全部广播成(bs,T),然后挨个比较再反向赋值

最终返回的能够对上len长度

注意~mask是取反,对False设置value值

2.加性注意力

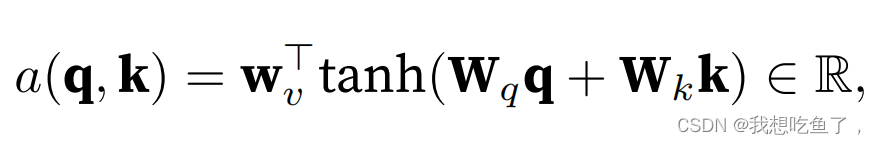

公式:

用在query与key向量长度不同时,使用两个权重相乘让他们相同,再做内积,等价于将二者合并后送入MLP:

实现:

#@save

class AdditiveAttention(nn.Module):"""加性注意⼒"""def __init__(self, key_size, query_size, num_hiddens, dropout, kwargs):super(AdditiveAttention, self).__init__(kwargs)self.W_k = nn.Linear(key_size, num_hiddens, bias=False)self.W_q = nn.Linear(query_size, num_hiddens, bias=False)self.w_v = nn.Linear(num_hiddens, 1, bias=False)self.dropout = nn.Dropout(dropout)def forward(self, queries, keys, values, valid_lens):queries, keys = self.W_q(queries), self.W_k(keys)# 在维度扩展后,# queries的形状:(batch_size,查询的个数,1,num_hidden)# key的形状:(batch_size,1,“键-值”对的个数,num_hiddens)# 使⽤⼴播⽅式进⾏求和features = queries.unsqueeze(2) + keys.unsqueeze(1)features = torch.tanh(features)# self.w_v仅有⼀个输出,因此从形状中移除最后那个维度。# scores的形状:(batch_size,查询的个数,“键-值”对的个数)scores = self.w_v(features).squeeze(-1)self.attention_weights = masked_softmax(scores, valid_lens)# values的形状:(batch_size,“键-值”对的个数,值的维度)return torch.bmm(self.dropout(self.attention_weights), values) 最终得到的是(bs,q,values),对每个query都会拿到长为values维度的向量。

重点在forward里面的广播,对于query(bs,q,h)与key(bs,k-v,h),将两个扩充为(bs,q,1,h)与(bs,1,k-v,h),再通过广播相加,最后再激活,通过最后Linear变成(bs,q,k-v,1)。注意,最后维度为1,所以可以压缩掉最后的维度。

scores里面mask的解读:先将score处理成valid_len后的值替换成-1e6(很小的数),再进行softmax,使得valid_len后面的得分都是0

bmm里面的权重为(bs,q,k-v),values为(bs,k-v,values),进行bmm矩阵乘法最终得到(bs,q,values)

验证一下,可看到queries中为(bs,q,q_size),keys(bs,k-v,k_size),values(bs,k-v,values)为(2,10,4)

最终得到为(bs,q,values)

queries, keys = torch.normal(0, 1, (2, 1, 20)), torch.ones((2, 10, 2))

# values的⼩批量,两个值矩阵是相同的

values = torch.arange(40, dtype=torch.float32).reshape(1, 10, 4).repeat(2, 1, 1)valid_lens = torch.tensor([2, 6])

attention = AdditiveAttention(key_size=2, query_size=20, num_hiddens=8,dropout=0.1)attention.eval()

attention(queries, keys, values, valid_lens)'''

tensor([[[ 2.0000, 3.0000, 4.0000, 5.0000]],[[10.0000, 11.0000, 12.0000, 13.0000]]], grad_fn=<BmmBackward0>)

'''3.缩放注意力

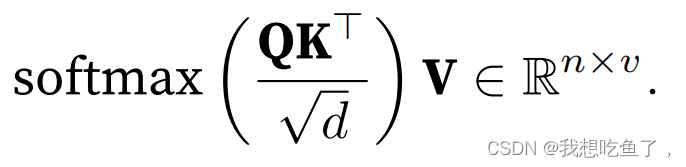

公式:

用于query与key长度相同,故可做转置后相乘--内积。

注意transpose,是进行将k转置再与queries做内积

#@save

class DotProductAttention(nn.Module):"""缩放点积注意⼒"""def __init__(self, dropout, kwargs):super(DotProductAttention, self).__init__(kwargs)self.dropout = nn.Dropout(dropout)# queries的形状:(batch_size,查询的个数,d)# keys的形状:(batch_size,“键-值”对的个数,d)# values的形状:(batch_size,“键-值”对的个数,值的维度)# valid_lens的形状:(batch_size,)或者(batch_size,查询的个数)def forward(self, queries, keys, values, valid_lens=None):d = queries.shape[-1]# 设置transpose_b=True为了交换keys的最后两个维度scores = torch.bmm(queries, keys.transpose(1,2)) / math.sqrt(d)self.attention_weights = masked_softmax(scores, valid_lens)return torch.bmm(self.dropout(self.attention_weights), values)验证一下,仍是得到(bs,q,values)

queries = torch.normal(0, 1, (2, 1, 2))

attention = DotProductAttention(dropout=0.5)

attention.eval()

attention(queries, keys, values, valid_lens)'''

tensor([[[ 2.0000, 3.0000, 4.0000, 5.0000]],[[10.0000, 11.0000, 12.0000, 13.0000]]])

'''该方法实现简单,但是可学习的参数少,几乎没有。