PPO算法-理论篇

1. Policy Gradient

【李宏毅深度强化学习笔记】1、策略梯度方法(Policy Gradient)

李宏毅深度强化学习-B站

2. PPO

PPO 算法

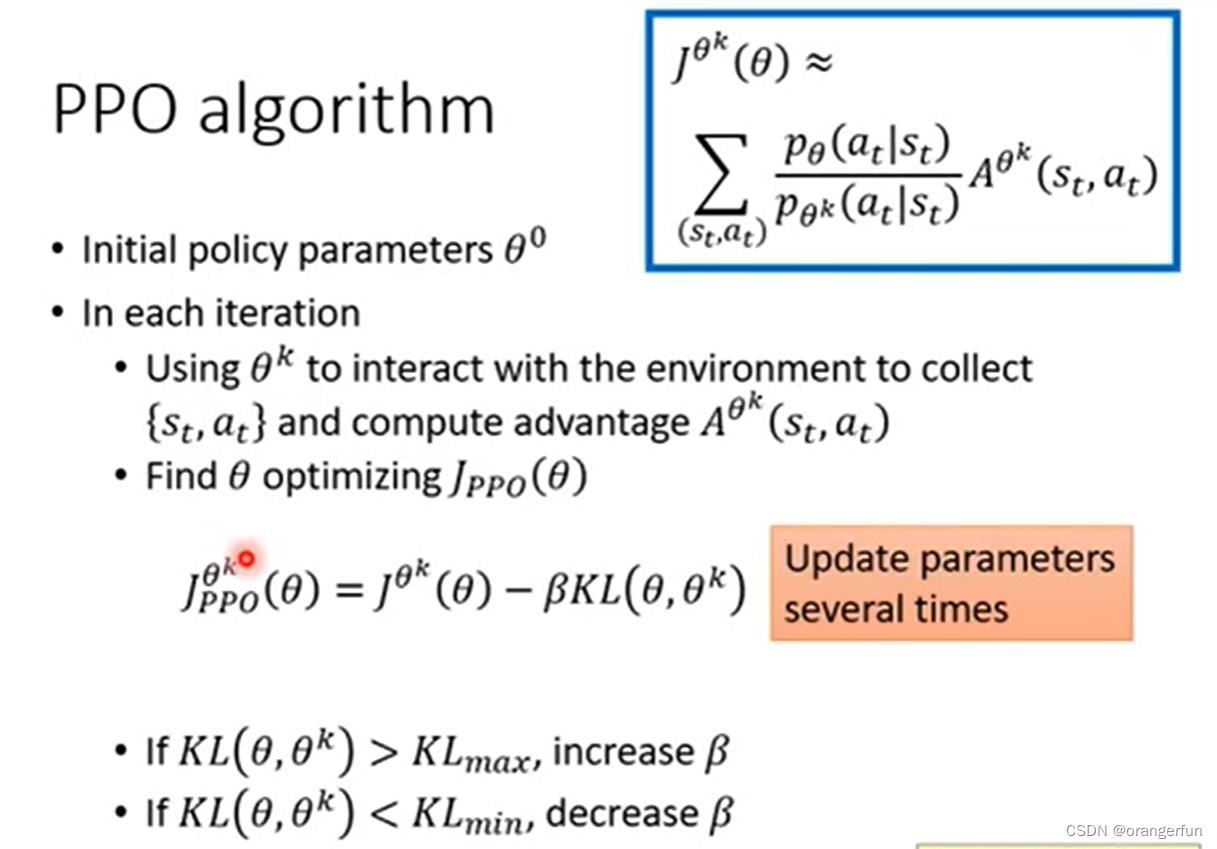

PPO算法更新过程如下:

- 初始化policy参数θ0\\theta^0θ0

- 在每一步迭代中:

- 使用θk\\theta^kθk与环境交互来收集数据{st,at}\\{s_t, a_t\\}{st,at},然后计算优势函数Aθk(st,at)A^{\\theta^{k}}(s_t, a_t)Aθk(st,at), θk\\theta^kθk是前一轮迭代得到的参数

- 优化目标函数JPPO(θ)J_{PPO}(\\theta)JPPO(θ),注意这里与policy gradient 不同,更新完参数可以继续训练,一直优化该目标函数,但是policy gradient更新完参数后必须重新采样

policy gradient 应该是每个mini batch更新参数后就要重新采样,而PPO可以跑完一个epoch再重新采样