跨模态检索论文阅读:Context-Aware Attention Network for Image-Text Retrieval

Context-Aware Attention Network for Image-Text Retrieval基于上下文感知的图文检索注意网络

Motivation:

以前的方法没有考虑到单模态中模态和语义的关联,本文提出了一个Context-Aware Attention Network,通过聚合上下文的信息,可以选择性的关注某一些局部的片段。除此之外,本文还提出了一个Semantics-based Attention (SA)来探索模态内的关系。

摘要

图像-文本双向检索在很大程度上依赖于每个图像-文本对的联合嵌入学习和相似性度量。先前的工作很少同时探索模态之间的语义对应和单一模态的语义关联。在这项工作中,我们提出了一个统一的上下文感知注意力网络工作(CAAN),它通过聚合全局上下文有选择地关注关键的局部片段(区域和单词)。具体来说,它同时利用全局模态间的对齐和模态内的关联来发现潜在的语义关系。考虑到检索过程中图像和句子之间的相互作用,模内关联来自于对区域-词排列的二阶关注,而不是直观地比较原始特征之间的距离。我们的方法在两个通用图像-文本检索数据集Flickr30K和MS-COCO上取得了相当有竞争力的结果。

简介

图像-文本双向检索是跨模态研究领域中最受欢迎的分支之一。它的目的是给定描述检索图像或从图像查询中找到句子。由于这两种模态之间存在巨大的差异,主要的挑战是如何学习联合嵌入并准确度量图像-文本的相似性。

在描述目标图像时,人们往往会频繁地提到突出的物体,并描述其属性和动作。基于这一观察,一些方法将图像中的区域和句子中的词映射到一个潜在的空间中,并探索它们之间的对齐。虽然验证了探索区域-词语对应关系的功效,但他们忽略了每个局部片段的不同重要性。最近,基于注意力的方法以不同的方式关注特定的区域和单词,并在图像-文本检索任务中显示出非常有希望的结果。SCAN是一个典型的基于另一种模态的片段来决定片段的重要性,旨在发现完整的区域-词的对齐。然而,它忽略了单一模态的片段之间的语义相关性(共同或排斥的属性、类别、场景等)。此外,一些工作已经提出,要么用预先训练的神经场景图生成器学习视觉关系特征,要么根据模态内的关系消除不相关的片段,这在一定程度上缓解了上述问题。

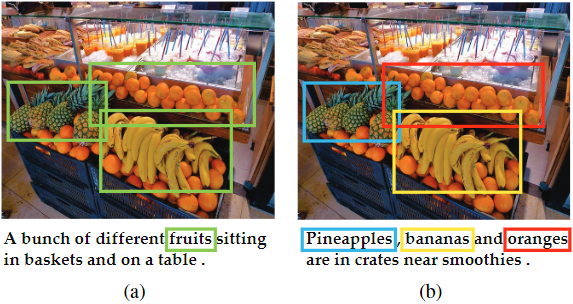

然而,以前大多数基于注意力的方法忽略了一个词或区域在不同的全局上下文中可能具有不同的语义这一事实。 具体来说,全局上下文指的是两种模态之间的交互和对齐(模态间上下文)以及单一模态中的语义总结和关联(模态内上下文)。如图1所示,人们有时会根据图1(a)中物体之间的关系自动总结高层次的语义概念(如水果),有时会在图1(b)中单独描述每个物体(如菠萝、香蕉、桔子)。 因此,同时考虑模态内和模态间的上下文,并在适应各种上下文的情况下进行图像-文本双向检索是有好处的。为了解决上述问题,我们首先提出了一个统一的上下文感知注意网络(CAAN),在全局上下文的基础上选择性地关注局部片段。 它将图像-文本检索制定为一个注意过程,它整合了模态间注意以发现词-区域对之间所有可能的对齐,以及模态内注意以学习单一模态中片段的语义相关性。通过利用上下文感知的注意力,我们的模型可以同时形成图像辅助的文本注意力和文本辅助的视觉注意力。因此,为片段分配的注意分数集合了上下文信息。

图1. 不同上下文下的自适应检索过程的说明。一张图片上有两个不同的句子。(a)中绿色突出的区域对应于左句中的 “水果”。然而,对应于 (b)中分别用蓝色、黄色和红色表示右句中的 “菠萝”、"香蕉 "和 “橙子”。

我们没有直观地使用基于特征的相似性,而是进一步提出了基于语义的注意(Semantics-based Attention,SA)来探索模态内的相关关系。我们的基于语义的注意被表述为区域-词语对齐的二阶注意,它明确地考虑了模态之间的相互作用,并有效地利用区域-词语的关系来推断单一模态中的语义相关性。它知道当前的输入对,来自图像-文本对的综合上下文可以直接影响检索过程中彼此反应的计算。因此,它根据给定的上下文实现了实际的自适应匹配。

综上所述,我们工作的主要贡献如下:

- 我们提出了一个统一的上下文感知注意力网络工作,从全局角度根据给定的上下文自适应地选择信息片段,包括单一模态的语义相关性和区域与单词之间可能的对齐。

- 我们提出了基于语义的注意力,以捕捉模态内的相关关系。它是区域-词语对齐的可解释的二阶注意。

- 我们在两个基准数据集Flickr30K[46]和MS-COCO[24]上评估了我们提出的模型,它取得了相当有竞争力的结果。

方法

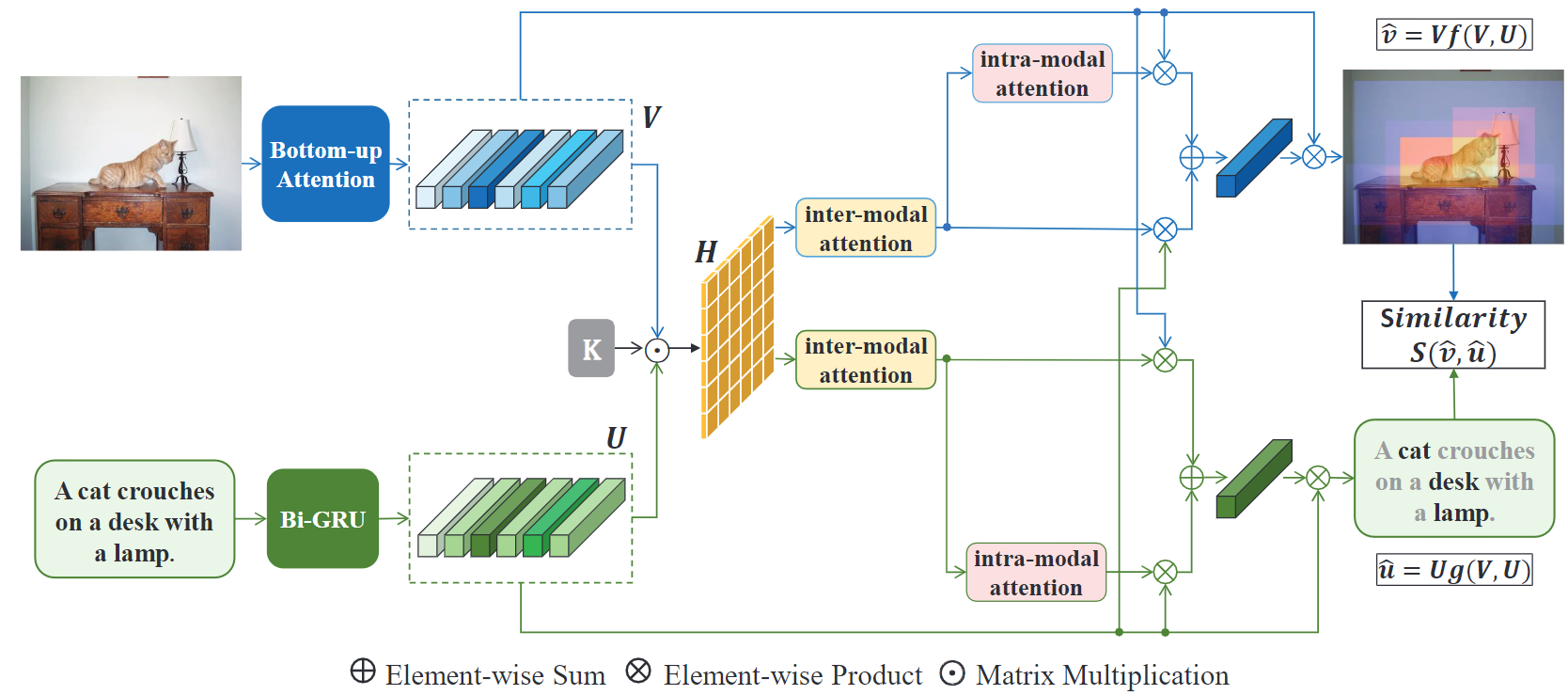

这一节将介绍我们提出的上下文感知注意力网络(CAAN)的概况。如图2所示,给定一个图像-文本对,我们首先将图像中的区域和句子中的词嵌入到一个共享空间。具体来说,自下而上的注意力被用来生成图像区域和它们的表示。同时,我们将句子中的词与句子的上下文一起进行编码。在关联模块中,我们在提取的局部片段的特征上执行我们的上下文感知注意力网络,它捕捉到区域-词对之间的语义对齐和单一模态中片段之间的语义关联。最后,用图像-文本匹配损失来训练该模型。

图2. 我们提出的上下文感知注意力网络(CAAN)的pipeline。它包括三个模块,(a)Bottom-Up attention和Bi_GRU用于分别提取和编码图像中的区域和句子中的单词,(b)context-aware attention用于提取跨模态的全局信息,即region-word之间的语义关联和单模态的语义关联,以及(c )用双向ranking loss联合优化最终表示。

视觉表征

我们利用Faster R-CNN模型结合ResNet-101分两个阶段检测每个图像中的目标和其他突出区域。对于每个区域i,xi表示具有2048维的原始均值池卷积特征。最终的特征vi通过xi的线性映射转化为D维向量,如下所示。

文字表征

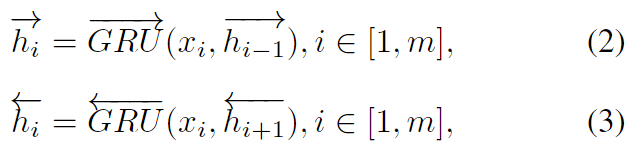

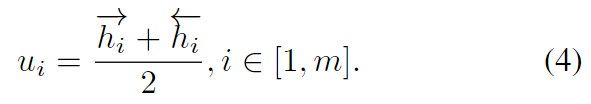

为了发现区域与单词的对应关系,句子中的单词被映射到与图像区域相同的D维空间。我们没有单独处理每个词,而是考虑一次对词和它的上下文进行编码。给出一个句子中m个输入词的one-hot编码W,我们首先通过词嵌入层将它们嵌入到300维的向量中,作为xi=Wewi,其中We是一个端到端学习的参数化矩阵。然后我们将向量送入双向GRU,写成:

两个hi分别表示来自前向和反向的隐藏状态。最后的单词嵌入ui是双向隐藏状态的平均值。

上下文感知注意力

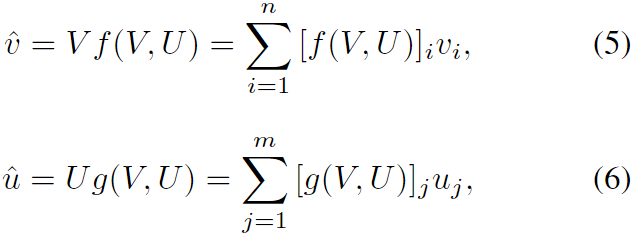

注意力机制的目的是关注相应任务中最相关的信息,而不是平等地使用所有可用的信息。图像v-文本u检索的注意过程定义为:

模态间注意力:矩阵H计算出局部区域-词对的相似性。将相似性的阈值设为零,并将其归一化,以获得对齐分数。

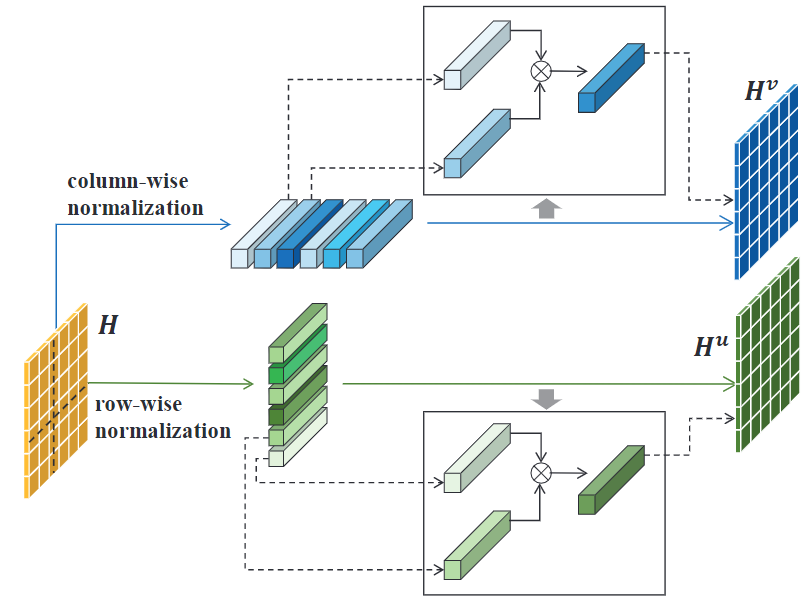

模态内注意力:

基于特征的注意(FA)。度量模态内相关的一个自然选择是计算特征的相似性。

基于语义的注意(SA)。考虑到检索过程中两个模态之间的相互作用和信息传递,我们提出了基于语义的注意,以探索基于区域-词关系的模态内的关联。

图3. 基于语义的模态内注意过程的详细图示。模态内密切矩阵Hv和Hu分别被设计用来捕捉潜在的区域与区域之间和词与词之间的关系。它们是通过充分利用模态间的排列组合来计算的。

实验

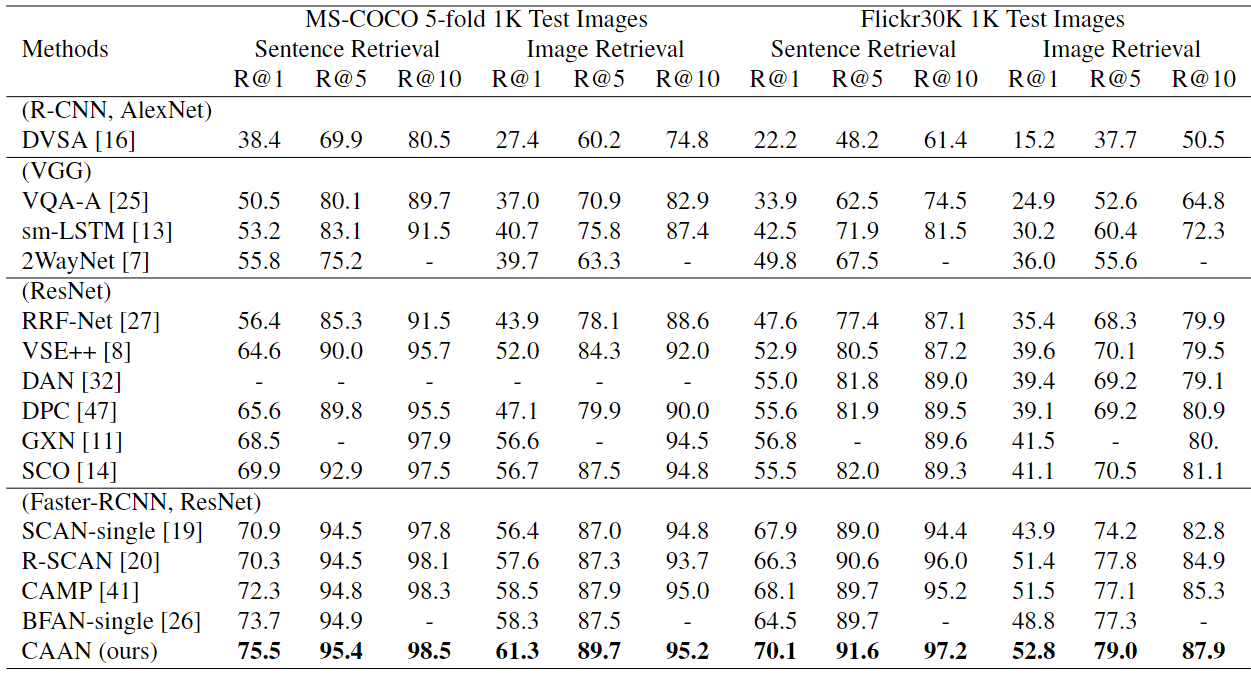

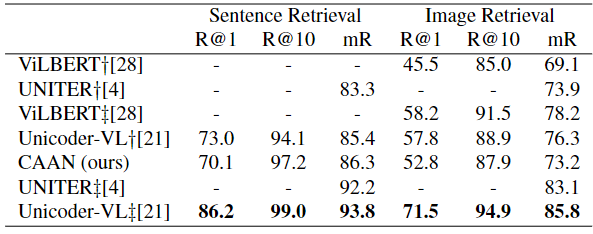

表1: 在MS-COCO 5折1K测试集和Flickr30K 1K测试集上的跨模态检索结果。最佳性能用粗体字表示。‘-’:没有提供结果。

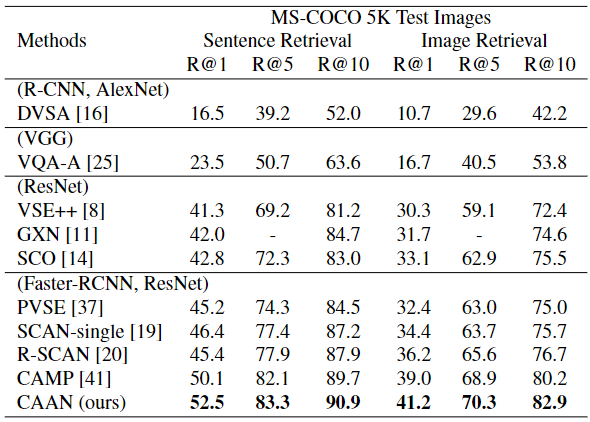

表2: 对MS-COCO全5K测试集的跨模态检索结果的比较。

表3: 在Flickr30k数据集上与BERT-base的方法进行比较。CAAN(我们的)是基线模型,它使用在视觉基因组上预训练的Faster R-CNN,没有预训练语言模型。†表示同时使用预训练的视觉特征和语言模型(BERT)初始化的方法,只使用纯文本数据。‡表示用额外的域外(视觉-语言)数据预训练的方法。

消融研究

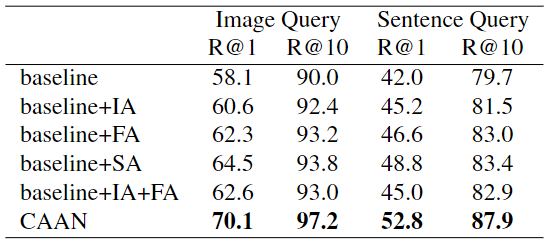

表4: 对Flickr30K测试集的消融研究结果。

带有模态间注意的基线:“基线+IA”。证明了它在考虑区域-词对之间的完全对齐方面的有效性。

基线与模态内注意:"基线+FA "和 "基线+SA ",表明通过自适应测量响应向量的距离而不是原始特征来推理语义关联的优势。

同时具有模态间和模态内注意的基线:"基线+IA+FA "和 “CAAN”,与 "基线+FA "相比,"基线+IA+FA "的结果甚至略差。这表明,如果没有精心的设计,将模态间排列和模态内相关结合起来可能会损害性能。而 "CAAN "优于 "baseline+IA+FA "和 “baseline+SA”,表明它是考虑全局背景并以互动方式进行语义关联挖掘的更好的解决方案。

图4. 在MS-COCO和Flickr30K数据集上,每个图像区域相对于句子查询的注意力权重的可视化。左边的子图(a)显示了用不同的句子进行文本到图像检索的定性例子。右边的子图(b)比较了 "基线+IA+FA "和我们的CAAN,这表明不同物体共享的相似语义会影响注意力的过程。以一种交互的方式考虑模态间的对齐和模态内的关联是有益的。

结论

在本文中,我们提出了一个统一的上下文感知注意力网络(Context-Aware At-tention Network,CAAN),将图像-文本检索表述为一个注意力过程,以选择性地关注信息量最大的局部片段。通过整合模内和模间的注意力,我们的模型聚合了词区对之间的对齐信息(模间上下文)和单一模态中片段之间的语义关联(模内上下文)。 此外,我们还进行了基于语义的注意力来模拟模内关联,这是区域-词对齐的可解释的二阶注意力。该模型在Flickr30K和MS-COCO数据集上取得了相当有竞争力的结果,从而证明了其有效性。

相关阅读:

CVPR2020-Image-Text Retrieval

全文翻译

公式理解