图像处理数据集

BSDS500

Berkeley Segmentation Dataset 500 是第一个用于评估超像素算法的数据集。对于参数优化,使用了验证集。

500张数据集=200训练集train+100验证集val+200测试集test

每张图像有 5 个不同的高质量地面真值分割(groundTruth,是.mat文件)

1.从这里下载BSDS500数据集

2.把

BSR/BSDS500/data提取到data/BSDS500(覆盖data/BSDS500/images和data/BSDS500/csv_groundTruth所提供的例子)。还要注意,之后有三个文件夹:groundTruth、csv_groundTruth和images。

3.在lib_tools/bsds500_convert_script.m中,调整目录的路径,即正确设置BSDS500_DIR。

4.Run the script. 这需要花费一些时间。

说明还可以在

lib_tools/bsds500_convert_script.m中查看。

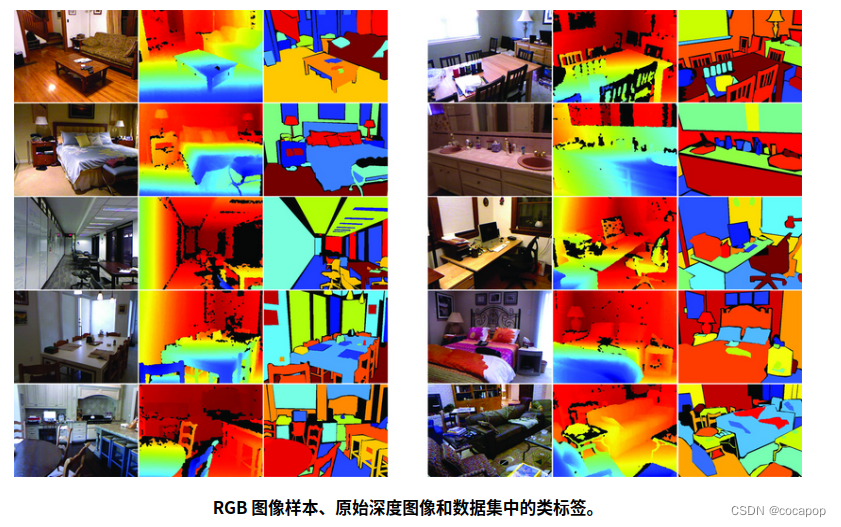

NYUV2

NYU Depth Dataset V2=1449张带有预处理深度的图像。ps.室内场景数据集

该数据集提供了带有实例标签的语义基础真值分段。按照Ren和Bo的做法,对地面实况进行了预处理,以去除未标记的小段。

(随机选择作为)验证集199张+399张测试集

具有的特点:

1、1449个密集标记的RGB和深度图像对齐对

2、来自3个城市的464个新场景

3、407,024个新的未标记帧

4、每个对象都标有一个类和一个实例号(cup1,cup2,cup3等)

数据集包含几个组成部分:

Labeled Dataset(标记数据集):是原始视频数据的子集它由成对的RGB和深度帧组成,这些帧已同步并为每个图像标注了密集标签。此数据还包含了一组预处理的深度图,其缺失值已使用Levin等人的着色方案进行了填充。与raw数据集不同的是,带有标签的数据集作为Matlab .mat文件提供,具有以下变量:...(网站链接里写了)

Raw Dataset(原始数据集):Kinect提供的原始rgb,深度和加速度计数据。RGB和深度相机的采样率介于20到30 FPS(随时间变化)。当帧不同步时,每个RGB,深度和加速度计文件的时间戳都作为每个文件名的一部分包含在内,可以使用工具箱中的get_synched_frames.m函数进行同步以产生连续的视频。

工具箱:matlab 工具箱有几个处理数据的有用函数。用于处理数据和标签的有用功能。

在对未标记的区域进行瘦身后,地面实况被转换为.csv文件。

转换后的数据集可在数据存储库中找到: davidstutz/superpixel-benchmark-data.

为了手动转换NYUV2数据集并提取使用的验证和测试子集,请使用lib_tools/nyuv2_convert.script.m

- 从这里下载数据集。确认下载的

文件是:nyu_depth_v2_labeled.mat.- 把数据放在

data/NYUV2/.中- 确保

data/NYUV2包含nyuv2_test_subset.txt,nyuv2_train_subset.txt,nyuv2_test.txt,nyuv2_train.txt.- 在lib_tools/nyuv2_convert.script.m中,设置NYUV2_DIR指向data/NYUV2目录。

- Run the script. 这需要花费一些时间。

说明还可以在

lib_tools/nyuv2_convert.script.m中查看

SBD

斯坦福背景数据集(SBD)结合了几个数据集的715张图像。这些图像的大小、质量和场景各不相同。所提供的语义基础真实分割需要进行预处理,以保证连接成分。

(随机选择作为)验证集238张+477张测试集

groundTruth被转换为.csv文件。转换后的数据集可在数据存储库中获得: davidstutz/superpixel-benchmark-data.

要手动转换SBD并选择验证和测试图像,请遵循lib_tools/sbd_convert_script.m:

- 从这里 下载数据集

- 提取数据集,使数据/SBD包含两个文件夹:图像(images)和标签(

labels.)。- 确保

data/SBD包含sbd_test.txt和sbd_train.txt.- 在lib_tools/sbd_convert_script.m中,调整下面的变量SBD_DIR,以匹配data/SBD的路径。

- Run the script.

说明还可以在 lib_tools/sbd_convert_script.m中查看

SUNRGBD

SUNRGBD数据集包含10335幅图像,包括预处理的深度。

该数据集提供了语义上的地面真实分割,需要进行类似于NYUV2数据集的预处理。

(随机选择)验证集200+测试集400。也包括在NYUV2数据集中的图像被忽略了。

The ground truth was converted to .csv files. The converted dataset is available in the data repository: davidstutz/superpixel-benchmark-data.

To manually convert the dataset, follow lib_tools/sunrgbd_convert_script.m:

- Download the SUNRGBD dataset from here.

- Make sure to download both the SUNRGBD V1 dataset and the SUNRGBDtoolbox containing the annotations.

- From the SUNRGBDtoolbox extract

SUNRGBD2dseg.matandSUNRGBDMeta.mattodata/SUNRGBD. - From the SUNRGBD V1 dataset extract all files into

data/SUNRGBD; note that this may take quite some time! It might be wise to extract the contained directories (xtion, realsense, kv1, kv2) separately. - In

lib_tools/sunrgbd_convert_script.m, adaptROOT_DIRto point to the data directory (i.e. the parent directory of the SUNRGBD directory). - Run the script. Note that this may take some time and memory.

The instructions are also found in lib_tools/sunrgbd_convert_script.m.

Fash

The Fashionista dataset [7] contains 685 images with semantic ground truth segmentations. The ground truth segmentations were pre-processed to ensure connected segments. Validation set and training set of size 222 and 463, respectively, were chosen at random.

The ground truth needs to be converted to .csv files using the steps in lib_tools/fash_convert_script.m:

- Download the Fashionista dataset from here.

- Extract fashionista_v0.2.1.mat into data/Fash.

- Adapt the below variables to match the path where

data/Fashcan be found. - Run the script. Note that this may take some time and memory.

位姿估计数据集:https://zhuanlan.zhihu.com/p/89951893